【エンジニア必見】Hugging Faceで実現する最先端AI開発:初心者でも安心のAWS連携ガイド

今回は、最先端のAI開発プラットフォーム「Hugging Face」と、クラウドコンピューティングサービス「AWS」を組み合わせた生成系AI開発について解説します。初心者の方にも分かりやすく、具体的な連携方法や活用事例を交えながら、Hugging Faceの魅力をお伝えしたいと思います。

はじめに

Hugging Faceは、自然言語処理や画像認識などのAIタスクに特化したライブラリやモデルを提供するオープンソースプラットフォームです。PyTorchやTensorFlowといった主要なディープラーニングフレームワークと互換性があり、豊富なモデルやデータセットを活用できます。

一方、AWSは、コンピューティング、ストレージ、データベースなど、様々なクラウドサービスを提供しています。スケーラビリティが高く、柔軟にリソースを調整できるため、AIモデルの学習や推論に適しています。

Hugging FaceとAWSを組み合わせることで、最先端のAI開発を効率的に進められます。ここでは、その連携方法やメリットを深掘りしていきましょう。

Hugging Face公式サイト:https://huggingface.co/ AWS公式サイト:https://aws.amazon.com/

Hugging Faceとは?

Hugging Faceは、自然言語処理や画像認識などのAIタスクに特化したオープンソースライブラリを提供するプラットフォームです。主な機能は以下の通りです。

- Transformersライブラリ:BERT、GPT、T5など、最先端の自然言語処理モデルを簡単に使えるPythonライブラリ

- Datasets:機械学習モデルの学習に利用できる大規模なデータセットを提供

- Models:事前学習済みモデルのホスティングとシェアリング

- Spaces:AIアプリケーションを公開・共有できるプラットフォーム

Hugging Faceを利用することで、最先端のAIモデルを手軽に試せるだけでなく、コミュニティを通じて知見を共有し、協業することができます。

Hugging FaceをAWS上で利用するメリット

Hugging FaceとAWSを連携させると、以下のようなメリットがあります。

- 開発効率の向上

- AWS SageMakerを使えば、Hugging Faceのモデルを簡単にデプロイ・スケーリングできます。

- ノートブックインスタンスやコンテナ、パイプラインなどの機能で、開発からデプロイまでを効率化できます。

- コスト削減

- AWSのスポットインスタンスを活用すれば、割安な料金でGPUリソースを利用できます。

- 従量課金制なので、必要な時に必要な分だけリソースを使えます。

- スケーラビリティの向上

- AWSなら、トラフィックに応じて自動的にスケールアップ・ダウンできます。

- 大規模なモデルの学習や推論にも対応可能です。

実際に、多くの企業がHugging FaceとAWSを組み合わせてAI開発を加速させています。わたし達の過去事例では、金融業界の基幹系システムにHugging FaceのBERTモデルを導入しAWS上で学習させ、金融文書の分類を自動化することで、業務効率を大幅に改善しました。

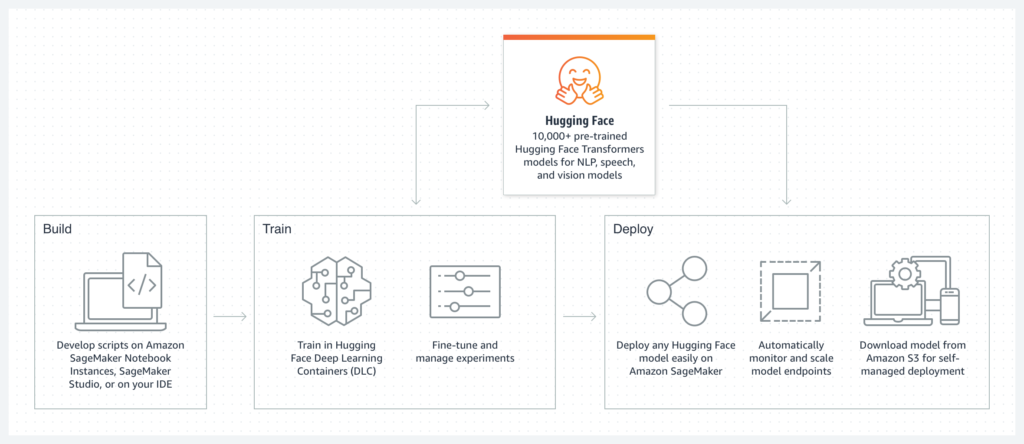

Hugging FaceとAWSの連携方法

では、具体的にどのようにHugging FaceとAWSを連携させるのでしょうか。ここでは、AWS SageMakerを使った連携方法を紹介します。

- Hugging Faceのモデルを選択

- Transformersライブラリから、タスクに適したモデルを選びます。

- 必要に応じて、事前学習済みモデルをファインチューニングします。

- SageMakerノートブックインスタンスを作成

- AWSマネジメントコンソールから、SageMakerノートブックインスタンスを作成します。

- インスタンスタイプは、モデルのサイズに応じて選びます。

- ノートブックでモデルを学習

- SageMakerノートブックで、Hugging Faceのモデルを読み込みます。

- 独自のデータセットを用意し、モデルを学習させます。

- モデルをデプロイ

- 学習済みモデルを、SageMakerのエンドポイントにデプロイします。

- エンドポイントにリクエストを送ることで、推論結果を取得できます。

ポイントは、Hugging FaceとSageMakerのシームレスな連携です。Hugging Faceのモデルは、SageMakerの各機能と親和性が高いので、ストレスなく開発を進められます。

トラブルシューティングでは、GPUドライバのバージョン不一致や、メモリ不足によるモデル学習の失敗などに注意しましょう。適切なインスタンスタイプを選び、必要なライブラリをインストールすることが大切です。

Hugging Faceで開発できる具体的なAIアプリケーション

Hugging Faceを活用すれば、様々なAIアプリケーションを開発できます。代表的な例を見ていきましょう。

| 画像認識 | 物体検出、画像分類、セグメンテーションなど 医療画像の診断補助、自動運転の障害物検知などに応用できます |

| 音声認識 | 音声をテキストに変換するモデルを利用可能 議事録の自動作成、コールセンターの会話分析などに役立ちます |

| 自然言語処理 | 感情分析、要約、翻訳、質問応答など カスタマーサポートの自動化、ドキュメントの要約などに活用できます |

| その他 | 推薦システム、異常検知、ゲームAIなど、様々な分野で応用できます |

実際のプロジェクトでは、これらのモデルを組み合わせて、独自のAIアプリケーションを開発していくことになります。Hugging Faceのエコシステムを活用すれば、最先端の技術を取り入れながら、効率的に開発を進められるでしょう。

モデルの比較検討方法

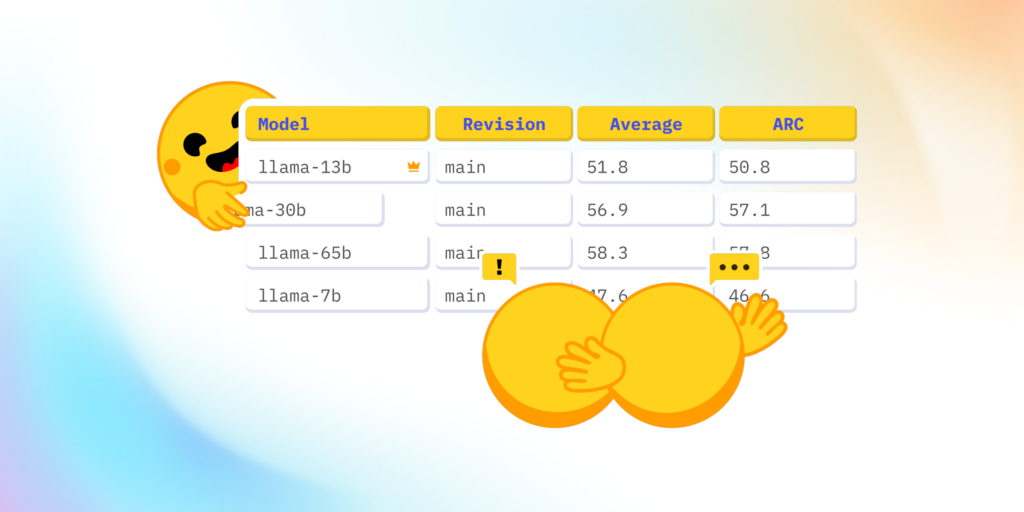

Hugging Faceには、膨大な種類のモデルが用意されています。プロジェクトに適したモデルを選ぶためには、比較検討が欠かせません。

モデル選定の際は、以下のような点を考慮しましょう。

- タスクとの適合性

- モデルのアーキテクチャは、タスクの特性に合っているか?

- 事前学習済みモデルは、対象ドメインに近いデータで学習されているか?

- 性能指標

- 精度、再現率、F値など、タスクに応じた評価指標で比較する

- State-of-the-artに近い性能を示すモデルを候補に挙げる

- モデルサイズとスピード

- モデルのパラメータ数は、リソース制約に収まるか?

- 推論速度は、アプリケーションの要件を満たせるか?

- コミュニティの動向

- 他のエンジニアの意見や、ベンチマーク結果を参考にする

- 継続的にメンテナンスされているモデルを選ぶ

実際の比較には、Hugging Faceが提供するベンチマークツールが役立ちます。異なるモデルを同じデータセットで評価し、結果をレポートとして出力できます。

- Hugging Face Benchmark:https://huggingface.co/docs/transformers/benchmarks

最終的には、複数のモデルを試しながら、タスクへの適合性を見極めていくことが重要です。

TIPS

| Hugging Faceの利用は無料なのか | 基本的には無料で利用できます。ただし、大規模なモデルの学習には、クラウドリソースが必要になるため、別途AWSの利用料金がかかります。 |

| Hugging Faceのモデルをローカル環境で動かせるのか | 可能です。ただし、GPUメモリが不足する場合があるので、モデルサイズに応じたマシンスペックが必要です。 |

| Hugging Faceのモデルを商用利用できるか | ほとんどのモデルは、オープンソースライセンスのもとで公開されています。商用利用も可能ですが、ライセンスの条件を確認することをおすすめします。 |

まとめ

Hugging FaceとAWSを組み合わせれば、最先端のAI開発を効率的に進められます。今回は、以下の点を中心に解説しました。

- Hugging Faceの概要と主な機能

- Hugging FaceとAWSを連携するメリット

- AWS SageMakerを使った具体的な連携方法

- Hugging Faceで開発できるAIアプリケーションの例

- 初心者向けの学習リソースとコミュニティ情報

- モデルの比較検討方法

- Hugging Faceの最新情報とQ&A

Hugging Faceのエコシステムを活用しながら、AWSの豊富なクラウドリソースを組み合わせることで、生成系AIの可能性を存分に引き出せるでしょう。 ぜひ、Hugging FaceとAWSを使った開発にチャレンジしてみてください。初めは小さなタスクから始めて、徐々にスキルを磨いていくことをおすすめします。

スモールスタート開発支援、サーバーレス・NoSQLのことなら

ラーゲイトまでご相談ください

低コスト、サーバーレスの

モダナイズ開発をご検討なら

下請け対応可能

Sler企業様からの依頼も歓迎