大規模データ移行プロジェクトの現実と向き合う

データ爆発時代における企業の苦悩

企業のデータ量は年々指数関数的に増加しています。IoTデバイスの普及、高精細な動画コンテンツ、詳細なログデータの蓄積など、データ生成源は多様化し続けています。IDCの調査によると、世界のデータ量は2025年までに175ゼタバイトに達すると予測されています。

オンプレミスのストレージインフラを運用する企業にとって、この急激なデータ増加は深刻な課題となっています。5年ごとのハードウェア更新サイクルでは、毎回予想を上回る容量が必要となり、予算超過が常態化しているケースも少なくありません。ある中堅製造業では、サーバー10台分のリプレースに毎回1000万円以上の費用がかかり、「1人情シス」体制では管理負荷が限界に達していました。

このような状況下で、AWS S3をはじめとするクラウドストレージへの移行は、単なる技術的な選択ではなく、ビジネス継続性を確保するための戦略的判断となっています。実際、Autodeskは約2.4PBのバックアップデータを分析し、必要データのみ700TBに圧縮することで約70%の削減を実現しました。このように、移行プロジェクトは単なるデータの引っ越しではなく、データガバナンスを見直す絶好の機会でもあります。

なぜAWS S3が選ばれるのか

圧倒的な耐久性と可用性

AWS S3が多くの企業に選ばれる最大の理由は、その「信頼性」にあります。S3は99.999999999%(11ナイン)という驚異的な耐久性を誇ります。これは、1億個のオブジェクトを保存した場合、1万年に1つ失われる可能性があるという計算になります。

オンプレミスで同等の耐久性を実現しようとすると、複数のデータセンターに冗長化システムを構築し、定期的なハードウェア更新と保守を継続する必要があります。これには莫大な初期投資と運用コストがかかります。一方、S3では標準でマルチAZ(アベイラビリティゾーン)冗長化が行われ、利用者は特別な設定なしにエンタープライズグレードの信頼性を享受できます。

スケーラビリティとコスト効率

S3の実質無制限のストレージ容量は、データの増加に悩む企業にとって大きな魅力です。容量計画に頭を悩ませる必要がなく、必要な時に必要なだけストレージを利用できます。従量課金モデルにより、初期投資を抑えながら、使った分だけ支払うという合理的なコスト構造を実現できます。

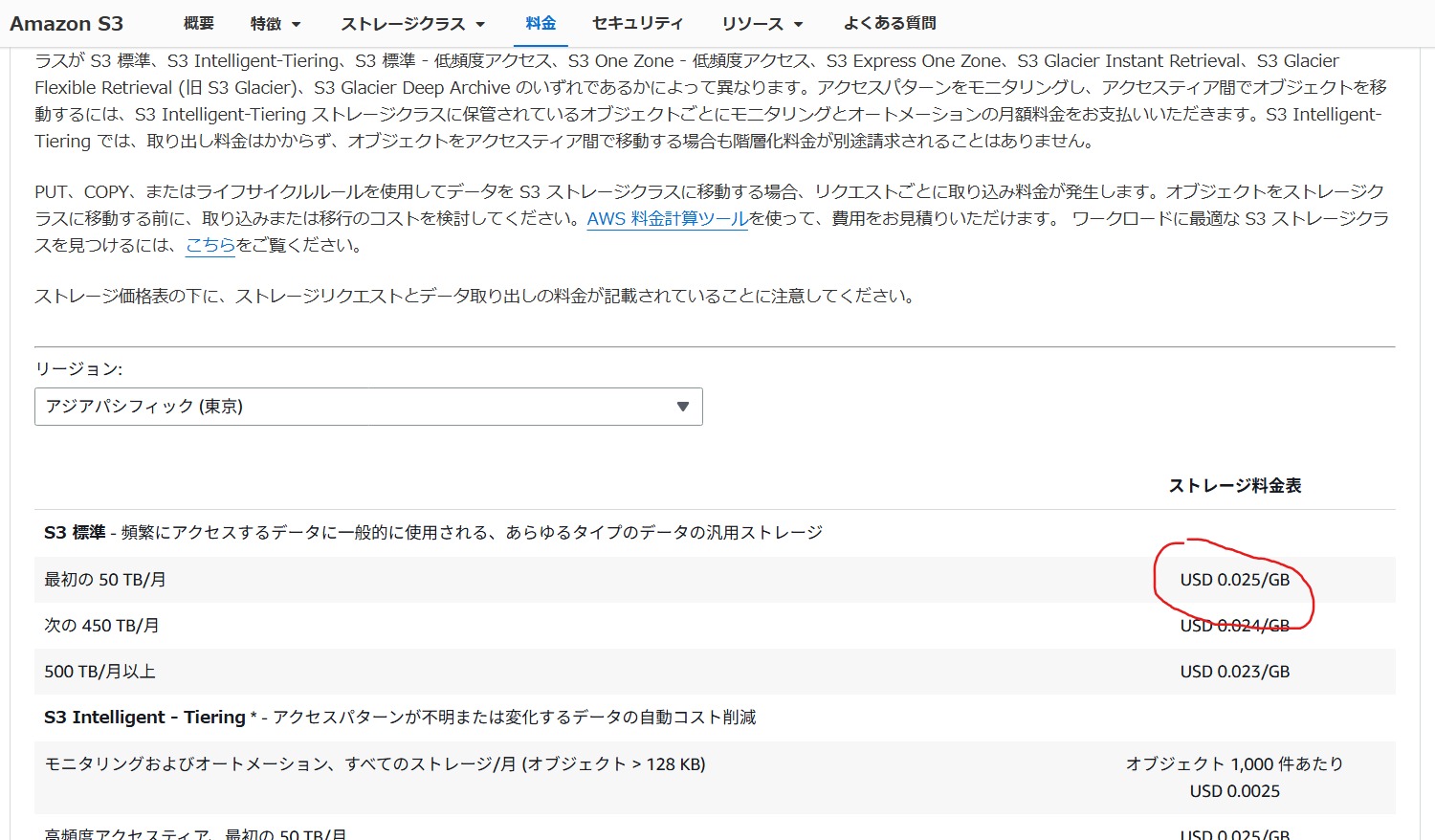

東京リージョンでのS3 Standardの料金は約$0.025/GB・月で、1TBあたり月額約3,750円という計算になります。これは、オンプレミスのTCO(総所有コスト)と比較して、多くの場合でコスト優位性があります。

移行プロジェクトの戦略的設計

段階的アプローチの重要性

フェーズ1:現状分析とデータクレンジング

100TB超のデータ移行において、最初のステップは徹底的な現状分析です。移行対象データの種類、ボリューム、アクセス頻度を詳細に分析することから始めます。多くの企業では、保存されているデータの30〜50%が重複データや不要データであることが判明します。

データクレンジングの具体的な手法として、以下のアプローチが有効です。

- 重複排除ツールを使用した同一ファイルの特定と削除

- アクセスログ分析による長期未使用ファイルの洗い出し

- 部門ごとのデータ保持ポリシーの見直しと標準化

- 法的要件を満たす最小限の保存期間の再定義

Autodeskの事例では、2.4PBのバックアップデータを精査した結果、実際に移行が必要なのは700TBのみでした。この事前整理により、移行時間とコストを大幅に削減できました。

フェーズ2:移行方式の選定

データ移行の方式選定は、プロジェクトの成否を左右する重要な意思決定です。主に「オンライン転送」と「オフライン転送」、そして両者の「ハイブリッド方式」という選択肢があります。

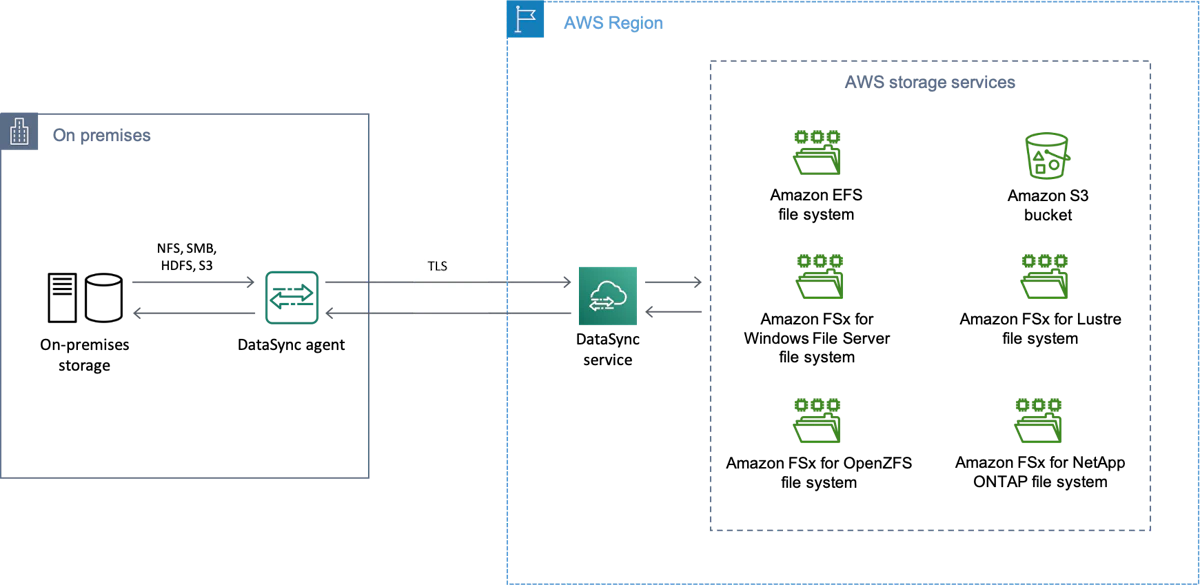

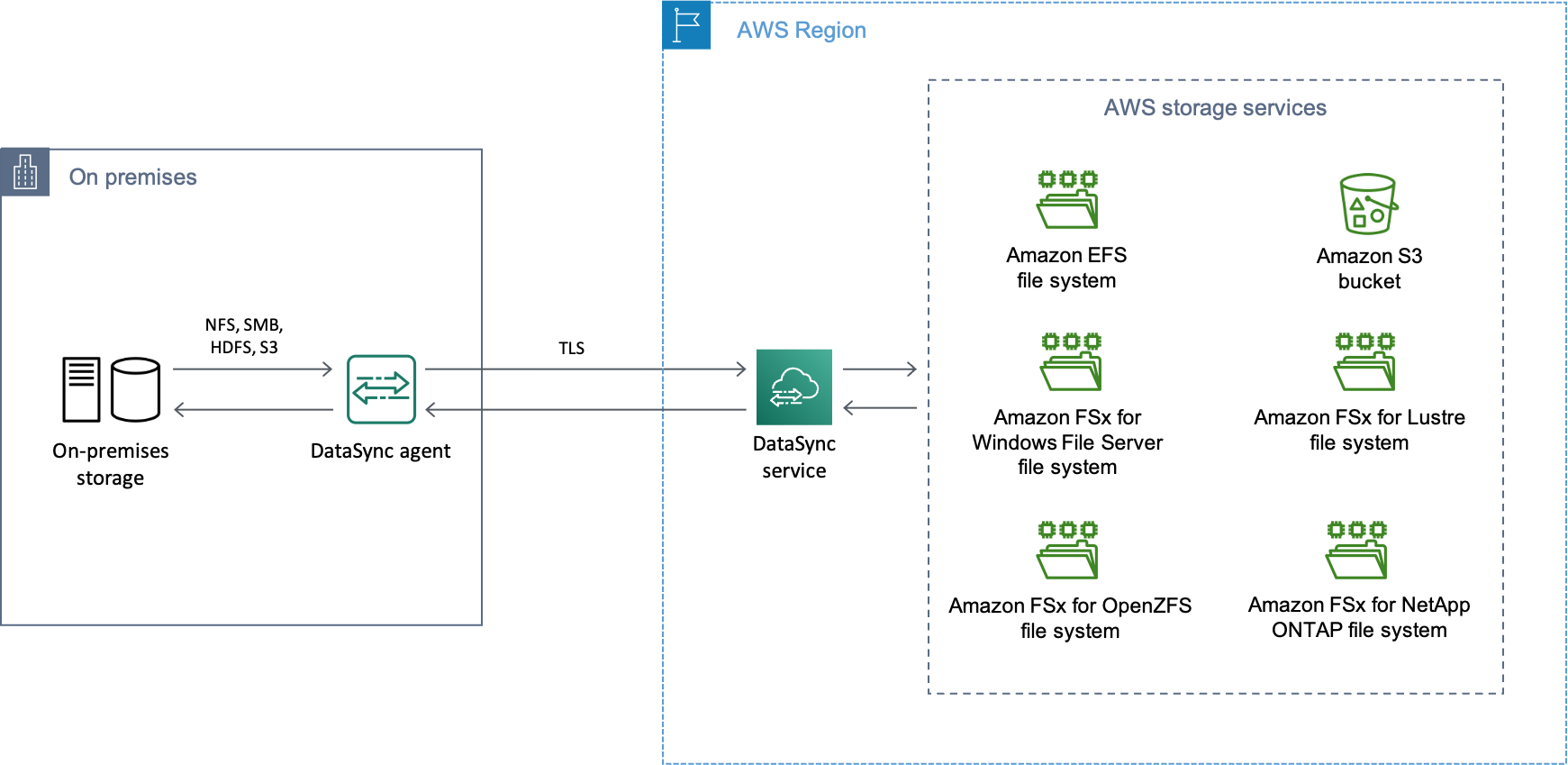

オンライン転送(AWS DataSync)の特徴

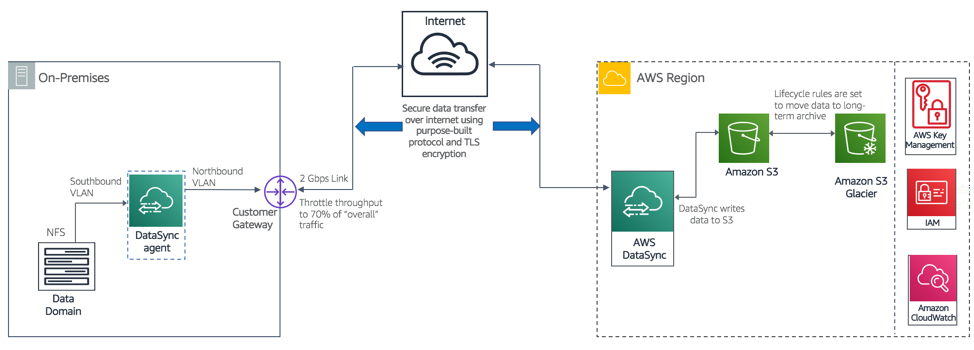

AWS DataSyncは、オンプレミスとAWS間のオンラインデータ転送を自動化・高速化するサービスです。NFSサーバーやSMB共有から直接S3へデータをコピーでき、最大10Gbpsのスループットを実現します。転送中はTLS暗号化により安全性が確保され、転送後には自動的に整合性検証が行われます。

.png)

DataSyncの実装では、オンプレミス環境にエージェントをデプロイし、ソースとデスティネーションを設定してタスクを実行します。帯域制限機能により、業務時間中は転送速度を抑え、夜間にフル稼働させるといった柔軟な運用が可能です。

オフライン転送(AWS Snowball)の特徴

AWS Snowball Edge Storage Optimizedデバイスは、1台あたり最大80TB程度のデータを格納可能な物理転送装置です。ネットワーク帯域が限られる場合や、短期間での大容量データ移行が必要な場合に有効です。デバイス内のデータは256ビットAESで自動暗号化され、安全にAWSデータセンターへ搬入されます。

100TB規模の移行では、Snowball Edge数台を並行使用することで、効率的な移行が可能です。例えば、1Gbps回線で100TB送ると理論上10日以上かかりますが、Snowballを使えば社内LANで短期間にコピーし、物理輸送できます。

2024 年 11 月 12 日をもって、AWS は前世代の AWS Snowball デバイスと Snowcone デバイス (HDD と SDD の両方) を廃止します。2025 年 11 月 12 日まで、これらの販売終了デバイスを使用している既存のお客様へのサポートを継続します。最新世代の AWS Snowball デバイスは、すべてのお客様にご利用いただけます。特定のデバイスと代替品の詳細については、ブログをご覧ください。

移行ツールの実践的な選び方

ネットワーク帯域と移行期限のバランス

移行方式の選定において、以下の計算式が参考になります。

必要転送時間(日)= データ量(TB)× 8,000 ÷ (実効帯域(Gbps)× 86,400 × 転送効率)例えば、100TBのデータを1Gbpsの専用線(転送効率70%)で転送する場合、約13日かかる計算になります。この期間が業務要件を満たさない場合は、Snowballやより高速な回線の検討が必要です。

Direct Connectによる安定した転送環境

AWS Direct Connectは、自社データセンターとAWSを専用線で直結するサービスです。10Gbpsの専用線を利用すれば、理論上100TBを1日程度で転送可能です。BBCの事例では、専用線を活用してピーク時1日120TBものデータ移行に成功しています。

Direct Connectの導入は初期コストがかかりますが、移行後も社内ネットワークとAWS間の低遅延接続として活用でき、長期的な投資価値があります。特に機密データの大規模移行では、セキュリティと安定性の観点からDirect Connect利用が推奨されます。

コスト最適化のための階層化戦略

S3ストレージクラスの戦略的活用

ストレージクラスの特性理解

AWS S3には用途に応じた複数のストレージクラスが用意されており、適切に使い分けることで大幅なコスト削減が可能です。

主要なストレージクラスと東京リージョンでの料金目安

ストレージクラス | 料金($/GB・月) | 最低保存期間 | 取り出し時間 | 主な用途 |

|---|---|---|---|---|

S3 Standard | 約0.025 | なし | 即時 | 頻繁にアクセスするデータ |

S3 Standard-IA | 約0.019 | 30日 | 即時 | 月1回程度アクセスするデータ |

S3 Glacier Instant Retrieval | 約0.005 | 90日 | 即時(ミリ秒) | 四半期に1回程度アクセスするアーカイブ |

S3 Glacier Flexible Retrieval | 約0.005 | 90日 | 数分〜数時間 | 年数回アクセスする長期保管データ |

S3 Glacier Deep Archive | 約0.002 | 180日 | 12時間 | ほぼアクセスしない長期保管データ |

この表が示すように、アクセス頻度に応じて適切なクラスを選択することで、ストレージコストを最大95%削減できます。

ライフサイクルポリシーによる自動最適化

S3のライフサイクル管理機能を活用することで、データの経年変化に応じた自動的なクラス遷移が可能です。例えば、以下のようなポリシーを設定できます。

作成から30日後 | Standard → Standard-IA |

|---|---|

作成から90日後 | Standard-IA → Glacier Instant Retrieval |

作成から365日後 | Glacier Instant Retrieval → Glacier Deep Archive |

このような段階的な遷移により、人手を介さずにコスト最適化を実現できます。Autodeskの事例でも、S3への移行後、一定期間保持したバックアップを自動でGlacier Deep Archiveにアーカイブするルールを設定し、長期保存コストを極小化しています。

Intelligent-Tieringによる自動最適化

アクセスパターンが予測困難な場合の解決策

S3 Intelligent-Tieringは、アクセスパターンに基づいて自動的にデータを最適なアクセス層に移動させるクラスです。30日間アクセスされなければIA相当の低コスト層へ、90日アクセスなければArchive Instant層へと自動的に遷移します。

Intelligent-Tieringの最大の利点は、取り出し手数料が不要である点です。アクセスが復活した場合、自動で高頻度層に戻され、利用者には標準S3と同じように即時データ提供されます。アクセス頻度を逐一管理できないデータレイク等では、このクラスをデフォルトにすることで、コスト最適化をAWS側に任せることができます。

TCOシミュレーションの実例

仮に100TBのデータを以下のように配分した場合のコスト試算です。

Standard(20TB) | $500/月 |

|---|---|

Glacier Deep Archive(80TB) | $160/月 |

合計 | $660/月(約99,000円) |

すべてをStandardで保存した場合の$2,500/月と比較すると、約74%のコスト削減となります。年間では約220万円の差額となり、5年間では1,100万円以上の削減効果が見込めます。

リスクマネジメントとガバナンス強化

データ移行時の主要リスクと対策

データ整合性の確保

大量のファイルを移行する際、最も重要なのは「データの完全性」を保証することです。AWS DataSyncでは、転送完了後に自動で整合性チェック(チェックサム検証)を行う機能があり、移行元と先のデータが一致することを確認できます。

実践的な検証プロセスとして、以下の手順を推奨します。

- 小規模なテストデータセットでの移行検証

- チェックサム値の比較による整合性確認

- サンプリングによるファイル内容の目視確認

- アプリケーションレベルでの動作確認

移行完了まではオンプレミス側のデータを削除せず、バックアップとして保持することも重要です。万一の不整合時にリカバリできる体制を整えておくことで、プロジェクトリスクを大幅に低減できます。

セキュリティとコンプライアンスの両立

クラウドへの機密データ移行において、セキュリティ確保は必須要件です。AWS DataSyncやSnowballでは、転送中のデータは自動的に暗号化されます。S3保管時も、デフォルトでAES-256によるサーバー側暗号化が適用可能です。

規制要件への対応として、S3 Object Lock機能を使用することで、WORM(Write Once Read Many)保護を実現できます。これにより、金融取引記録の7年間保存などの法定保存期間を確実に満たすことができます。コンプライアンスモードに設定すれば、AWS管理者であっても保持期間内は削除不可能な厳格な保護を提供します。

ガバナンス体制の構築

マルチアカウント戦略による権限管理

大容量データを扱う場合、適切なアクセス権限モデルの設計が重要です。AWSでは、マルチアカウント戦略により環境を分割し、各アカウントに権限境界を設けることができます。

実装例として、以下のような構成が有効です。

- 本番データ用アカウント:限定された管理者のみアクセス可

- 開発・検証用アカウント:開発チームがアクセス可能

- バックアップ用アカウント:読み取り専用で複製データを保持

- 監査用アカウント:CloudTrailログを集約し監査証跡を保管

このような多層防御により、データ漏洩リスクを最小化できます。

継続的なコスト監視と最適化

AWS Cost ExplorerやAWS Budgetsを活用することで、S3の利用コストを詳細に分析できます。特に注意すべき点として、以下の項目があります。

- データ転送(エグレス)料金の監視

- リクエスト数による従量課金の把握

- 不要なバージョニングやレプリケーションの削除

- ライフサイクルポリシーの定期的な見直し

月次でコストレビューを実施し、想定外の料金発生がないか確認する運用プロセスを確立することが重要です。

実際の移行プロジェクトから学ぶ教訓

成功事例の共通パターン

Autodesk社の事例から学ぶポイント

Autodeskは、2.4PBのバックアップデータを700TBに圧縮し、AWS DataSyncを使用して2.5か月で移行を完了させました。このプロジェクトから得られる重要な教訓は以下の通りです。

- 事前のデータクレンジングによる移行規模の最適化

- 新技術(DataSync)への柔軟な切り替え判断

- 段階的な移行アプローチによるリスク低減

- 移行後の自動アーカイブによる継続的なコスト最適化

プロジェクト担当者は「ペタバイト規模の移行が最小限の努力で迅速に完結し、ゲームチェンジャーだった」と評価しています。この成功要因は、技術選定の柔軟性と、ビジネス要件に基づいた意思決定の速さにありました。

BBC(英国放送協会)の大規模アーカイブ移行

BBCは100年分のアーカイブ映像・音源(25PB)をAWSに移行しました。専用線(Direct Connect)を活用し、ピーク時には1日120TBという驚異的なペースでデータ移行を実現しています。

この事例から学べる重要なポイントは、「インフラ投資の戦略的判断」です。専用線の導入は初期コストがかかりますが、移行スピードの向上と、移行後の継続的な活用を考慮すると、十分な投資価値がありました。結果として、ロンドン中心部のテープ保管設備の半分を撤去でき、物理スペースと電力を大幅に節減できました。

日本国内での導入事例と教訓

自治体DXにおけるクラウド活用

盛岡市は、自治体DX計画の一環で基幹系システムをガバメントクラウド(AWS)へ移設しました。5年間で総コスト8%削減を実現し、さらに従来実現できなかった遠隔地災害対策(DR)環境を構築できました。

東京リージョンから大阪リージョンへの定期的なバックアップデータ転送により、東日本大震災のような広域災害にも対応可能な体制を整えました。このように、クラウド移行は単なるコスト削減だけでなく、BCP(事業継続計画)の観点からも大きな価値をもたらします。

中堅製造業でのTCO削減事例

高砂金属工業では、サーバー10台分の業務システムをAWSに全面移行しました。5年毎のサーバー更新に毎回1,000万円以上かかっていた費用を大幅に削減し、「1人情シス」体制でも管理可能な環境を実現しています。

この事例は、人的リソースが限られる中堅・中小企業にとって、クラウド移行が運用負荷軽減の有効な手段であることを示しています。S3をバックアップストレージとして活用することで、少人数でも安全なデータ管理を実現できました。

今後の展望と推奨アプローチ

クラウドネイティブ時代のデータ管理

AIとの統合による新たな価値創出

クラウドへのデータ集約は、AI・機械学習との統合を容易にします。BBCの事例では、クラウド上に集約したアーカイブに対して、音声テキスト化や顔認識によるメタデータ付与を実施し、アーカイブの利活用が大幅に向上しました。

S3に保存されたデータは、Amazon Athenaによる直接クエリや、Amazon SageMakerでの機械学習モデル構築に即座に活用できます。これにより、単なるデータ保管から、データドリブンな意思決定を支援する戦略的資産へと進化させることができます。

マルチクラウド戦略の検討

AWS S3は優れたサービスですが、ベンダーロックインのリスクも考慮する必要があります。将来的には、Azure Blob StorageやGoogle Cloud Storageとの併用も視野に入れた、マルチクラウド戦略の検討が重要になるでしょう。

Oracle Cloud Infrastructure(OCI)のObject Storageは、毎月10TBまでの無料エグレス枠を提供しており、大量配信が必要な用途では魅力的な選択肢となる可能性があります。各クラウドの特性を理解し、ワークロードに応じて最適なサービスを選択する柔軟性が求められます。

移行プロジェクト成功への実践的推奨事項

段階的アプローチの徹底

100TB超の大規模データ移行では、以下の段階的アプローチを推奨します。

フェーズ | アプローチ |

|---|---|

①評価フェーズ(1-2か月) | 現状分析とデータクレンジング |

②PoC フェーズ(2-4週間) | 小規模データでの移行検証 |

③パイロット移行(1-2か月) | 重要度の低いデータから段階的に移行 |

④本番移行(2-3か月) | 計画的な本番データ移行 |

⑤最適化フェーズ(継続的) | コスト最適化とガバナンス強化 |

各フェーズで得られた知見を次のフェーズに活かすことで、リスクを最小化しながら確実に移行を進めることができます。

チェックリストによる移行準備の確認

移行開始前に、以下の項目を確認することを推奨します。

- データインベントリの完成度と分類の明確化

- ネットワーク帯域と移行スケジュールの整合性確認

- セキュリティ要件とコンプライアンス要件の文書化

- 移行ツールの選定と検証環境での動作確認

- ロールバック計画とリカバリ手順の策定

- ステークホルダーへの影響分析と合意形成

- 移行後の運用プロセスとサポート体制の確立

これらの準備を怠ると、移行中や移行後に予期せぬ問題が発生し、プロジェクトの遅延やコスト超過につながる可能性があります。

継続的な改善とイノベーション

クラウド移行は、ゴールではなく新たなスタートです。移行後も継続的な最適化を行い、新たなクラウドサービスを活用したイノベーションを追求することが重要です。

定期的にAWSの新サービスやアップデートをチェックし、自社のユースケースに適用可能か評価する体制を整えることをお勧めします。例えば、AWS DataZoneのようなデータガバナンスサービスや、Amazon DataExchangeを活用した外部データとの連携など、新たな価値創出の機会を探ることができます。

まとめ

100TB超の大規模データをAWS S3へ移行することは、技術的にも組織的にも大きなチャレンジですが、適切な戦略と実行により、確実に成功へ導くことができます。重要なのは、単なる「データの引っ越し」として捉えるのではなく、データガバナンスの改善、コスト最適化、そして新たな価値創出の機会として捉えることです。

本記事で紹介した実践的なアプローチと、実際の成功事例から得られた教訓を参考に、自社の状況に合わせた最適な移行計画を立案していただければ幸いです。クラウドネイティブ時代において、データは企業の最も重要な資産の一つです。その資産を最大限に活用するための第一歩として、AWS S3への移行プロジェクトを成功させることができるでしょう。

技術は日々進化していますが、本質的に重要なのは「ビジネス価値の創出」です。クラウド移行を通じて、組織のアジリティを高め、イノベーションを加速させる基盤を構築することこそが、真の成功と言えると感じます。