AI TRiSMの本質を理解する:統合的なAIガバナンスへの転換

AIシステムに潜む「見えないリスク」の正体

AIシステムの導入を検討する際、多くの企業が最初に直面するのは「このAIは本当に信頼できるのか」という根本的な疑問です。例えば、融資審査AIが特定の属性を持つ顧客に対して不公平な判断を下していないか、医療診断支援AIが誤った診断を下すリスクはないか、といった懸念は決して杞憂ではありません。

実際に、ガートナーの調査によれば、2026年までにAIの透明性・信頼性・セキュリティを実践する企業は、AIモデルの導入率やビジネス成果が50%向上すると予測されています。この数字が示すのは、AIのリスク管理が単なる守りの施策ではなく、ビジネス成功の必須要件になりつつあるという現実です。

従来、企業のAI活用において「信頼性確保」「リスク管理」「セキュリティ対策」はそれぞれ別個のフレームワークや基準で検討されてきました。データサイエンスチームはモデルの精度向上に注力し、セキュリティチームは外部攻撃への対策を講じ、法務部門はコンプライアンスを確認するといった具合に、各部門がサイロ化した状態で活動していたのです。

しかし、生成AIの急速な普及により、この縦割りアプローチの限界が明らかになってきました。例えば、大規模言語モデル(LLM)は高度な文章生成能力を持つ一方で、機密情報の漏洩リスクや偏見の増幅、さらには「ハルシネーション」と呼ばれる事実と異なる情報の生成など、従来のITシステムとは異なる複雑なリスクを内包しています。

AI TRiSMが提供する「統合的アプローチ」の価値

「AI TRiSM」は、これらの課題に対する包括的な解決策としてガートナー社のリサーチ部門によって提唱・開発された概念です。正式名称である「Artificial Intelligence Trust, Risk and Security Management」が示すとおり、AIシステムの信頼性(Trust)、リスク(Risk)、セキュリティ(Security)を統合的に管理することを目的としています。

AI TRiSMの革新的な点は、技術的な対策と組織的なガバナンスを融合させた点にあります。単にツールを導入するだけでなく、組織文化やプロセス、人材育成までを包含した総合的なアプローチを取ることで、AIリスクの本質的な解決を目指しています。

興味深いことに、ガートナーはAI TRiSMを2023年・2024年の主要技術トレンドの一つに挙げており、特に生成AI時代においては不可欠なフレームワークと位置づけています。実際、金融業界ではデンマークのビジネス当局(DBA)が16のAIモデルを迅速に展開・管理し、数十億ユーロ規模の取引を公正にモニタリングすることに成功するなど、既に具体的な成果が報告されています。

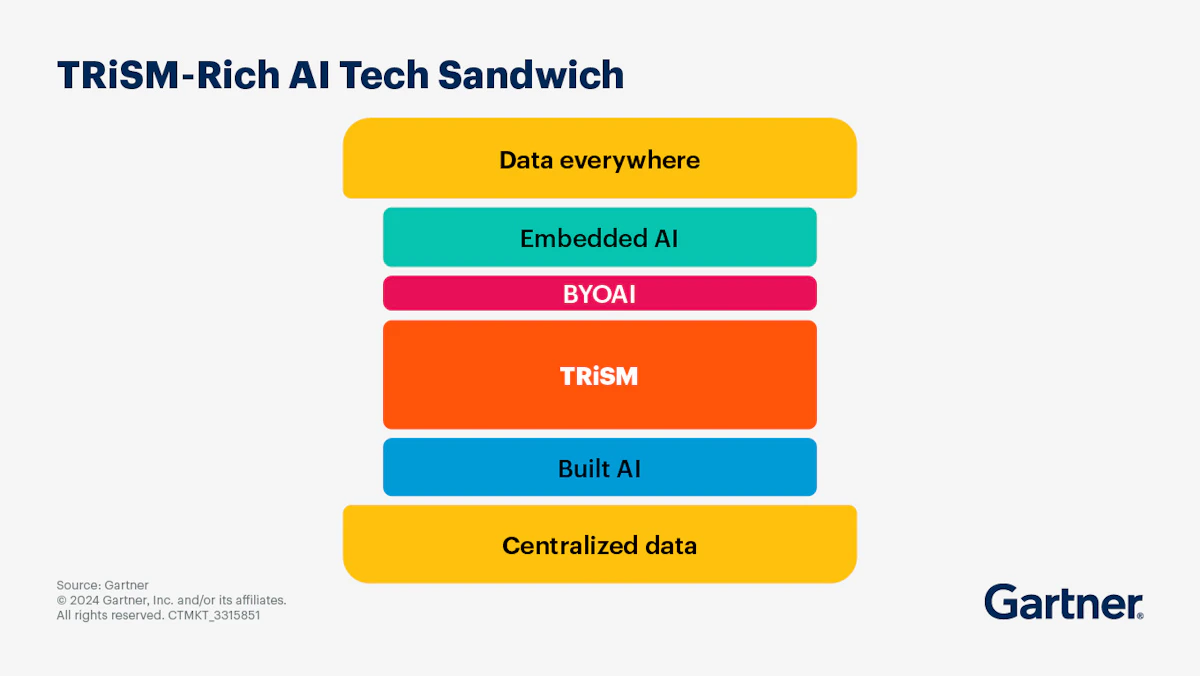

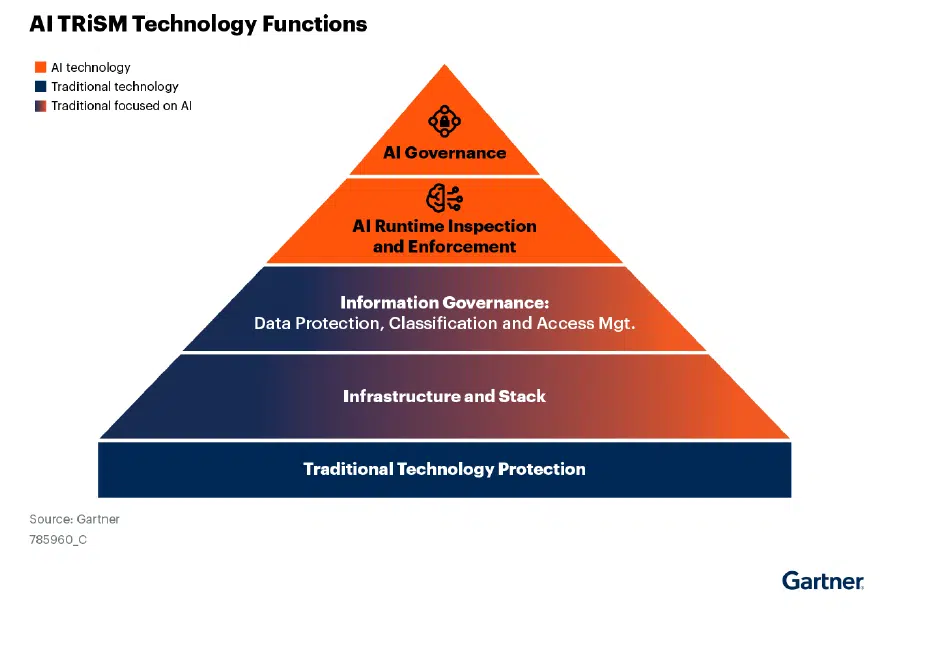

AI TRiSMを構成する5つの中核レイヤー

アーキテクチャの全体像と各層の役割

AI TRiSMのアーキテクチャは、複数のレイヤーが連携して機能する多層防御の構造を採用しています。それぞれのレイヤーが独立して機能しながらも、相互に補完し合うことで、AIシステム全体の信頼性と安全性を確保します。

AIガバナンス層:組織の意思決定の土台

最上位に位置する「AIガバナンス層」は、組織全体のAI利用方針や責任体制を確立する層です。ここでは倫理規定や法令遵守のルールを定め、ビジネス戦略と整合する形でAI開発・運用の指針を策定します。

私の経験から言えば、このガバナンス層の設計で最も重要なのは「現場の実態に即した実効性のあるルール作り」です。理想論だけで構築されたガバナンスは、結局のところ形骸化してしまいます。例えば、あるFinTech企業では、リスクレベルに応じて3段階の承認プロセスを設定し、低リスクのAIについては迅速な導入を可能にしながら、高リスクのAIには厳格な審査を適用するという柔軟な運用を実現しています。

AIランタイム検査・強制層:リアルタイムの安全網

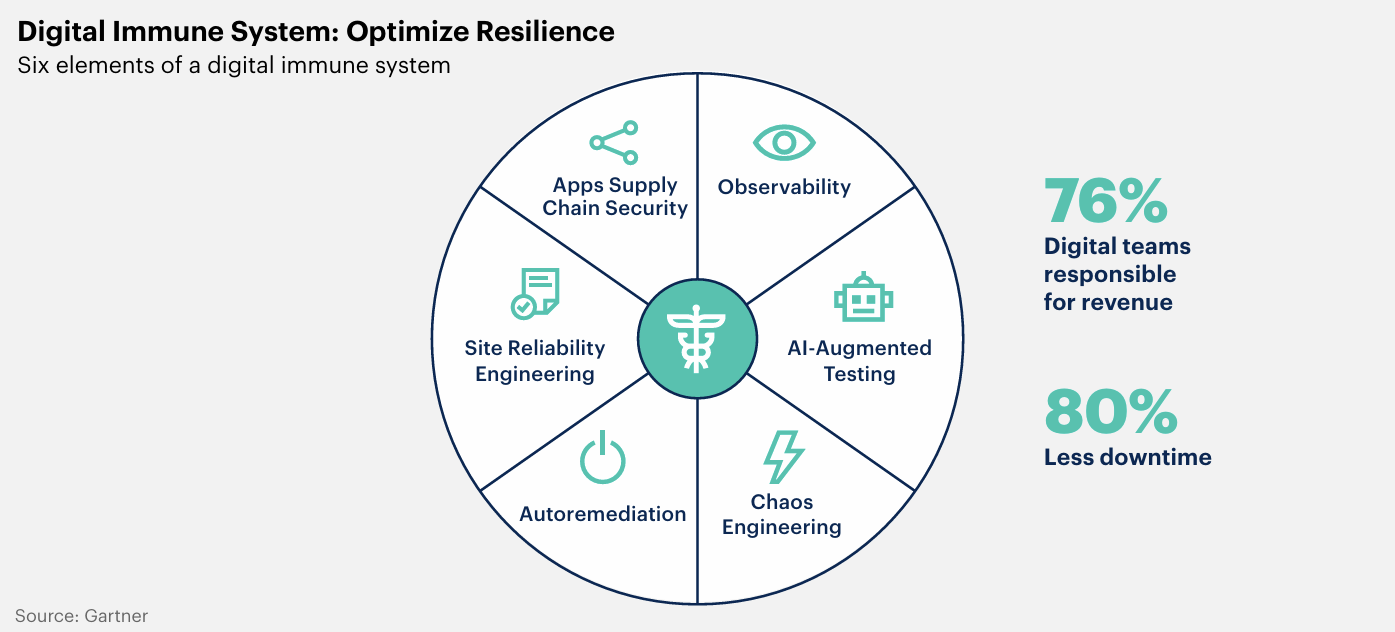

「AIランタイム検査・強制層」は、AIモデルやアプリケーションが実際に動作する際のリアルタイム監視を担当します。推論リクエストや出力結果を監視して、異常な入力・出力を検出し、必要に応じて自動ブロックや是正措置を行います。

この層の実装では、誤検知と見逃しのバランスが重要になります。あまりに厳格な制御を行うと、AIの利便性が損なわれ、逆に緩すぎると重大なインシデントを見逃す可能性があります。IBMによる解説でも触れられているように、機械学習を用いた異常検知と人間のレビューを組み合わせることで、このバランスを最適化することが可能です。

情報ガバナンス層:データの品質とプライバシーの守護者

「情報ガバナンス層」では、AIで扱うデータの品質・セキュリティ・プライバシーを管理します。データ分類、アクセス制御、暗号化、PIIマスキングなどの対策を通じて、AIモデルが不適切なデータによってリスクを生まないようにします。

特に注目すべきは、データの「系統管理(データリネージ)」です。AIモデルがどのデータを使って学習し、どのような変換を経て結果を出力したかを追跡可能にすることで、問題が発生した際の原因究明や説明責任の確保が可能になります。

インフラストラクチャー&スタック層:柔軟で堅牢な基盤

「インフラストラクチャー&スタック層」は、AIシステムを支える基盤全般の安全性と柔軟性を担保します。クラウドやオンプレミスといった様々な環境でAIがデプロイされることを想定し、環境依存のリスクやベンダーロックインを避ける設計が求められます。

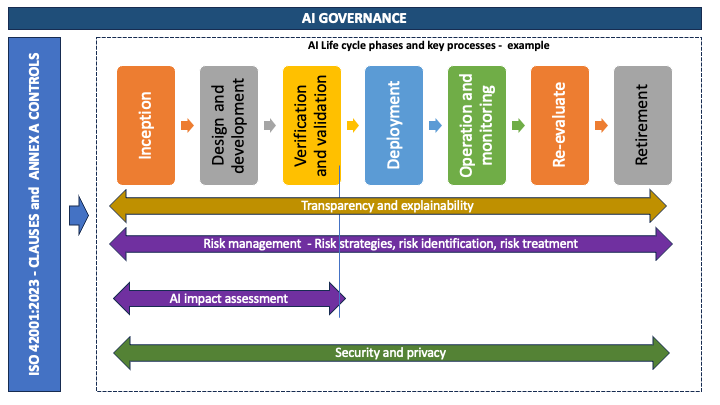

コンテナ技術やマイクロサービスアーキテクチャの採用により、異なる環境間での一貫したセキュリティ制御と監査が可能になります。AWSのセキュリティブログでも、ISO/IEC 42001:2023に準拠したAIライフサイクル管理の重要性が強調されています。

従来型セキュリティ制御:基本を忘れない

最後に、IAMやネットワークセキュリティ、暗号化といった「従来型のセキュリティ制御」も欠かせません。AIシステムだからといって特別扱いするのではなく、通常のITシステムと同様の基本的なセキュリティ要求を満たすことが前提となります。

実装に向けた具体的なプロセスと技術要素

モデルとデータの可視化から始める

AI TRiSMの実装において、最初のステップは「現状の把握」です。企業内で利用している全てのAIモデル、エージェント、アプリケーションをカタログ化し、それぞれのリスクレベルや用途を明確にします。

ある大手製造業の事例では、社内で稼働しているAIシステムを調査したところ、把握していたものの3倍以上のAI機能が様々な部門で独自に導入されていたことが判明しました。このような「シャドーAI」の存在は、組織全体のリスク管理において大きな盲点となります。

次に重要なのが「データマッピング」です。各モデルに関連するデータ(学習データ、評価データ、プロンプト、ログなど)を洗い出し、どのデータがどのモデルで使われているかを可視化します。個人情報や機密情報の有無を確認し、適切な保護手段が取られているかを検証します。

MLOpsパイプラインへのAI TRiSM統合

開発プロセスにAI TRiSMを組み込む際は、既存のMLOpsパイプラインを拡張する形で実装することが効果的です。CI/CDパイプラインに以下のようなステップを追加します。

「バイアス検査」のステップでは、モデルの学習・評価段階で公平性指標を測定します。例えば、採用支援AIの場合、性別や人種による採用率の偏りがないかを自動的にチェックし、必要に応じてデータのリバランシングやモデルの再調整を行います。

「説明可能性の検証」では、LIMEやSHAPといった手法を用いてモデルの判断根拠を可視化します。特に金融や医療といった規制の厳しい業界では、モデルの意思決定プロセスを説明できることが法的要件となる場合もあります。

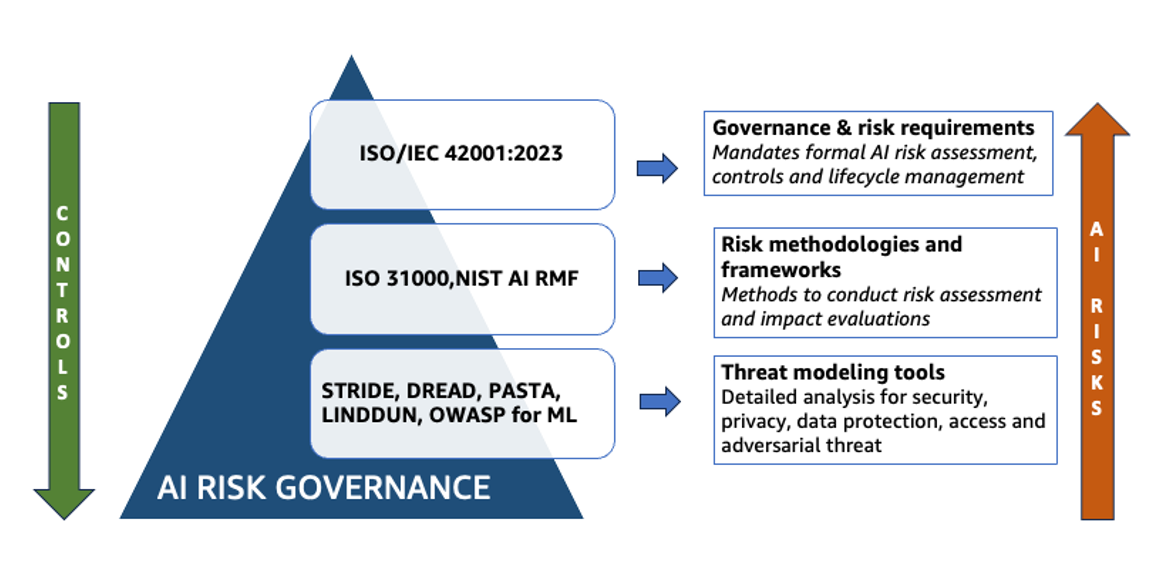

「セキュリティテスト」では、adversarial example(敵対的サンプル)による攻撃テストや、データポイズニング耐性テストを実施します。NISTのAIリスク管理フレームワークでも、こうした脆弱性診断の重要性が強調されています。

継続的モニタリングと改善のサイクル

本番環境にデプロイした後も、継続的なモニタリングが不可欠です。モデルの精度劣化(ドリフト)、異常な挙動、新たなセキュリティ脅威などを常に監視し、必要に応じて迅速な対応を取る体制を整えます。

興味深いのは、このモニタリングプロセス自体にもAIを活用できる点です。異常検知AIを用いて、他のAIシステムの挙動を監視するという「メタAI」のアプローチは、大規模なAI運用において効果的な手法として注目されています。

導入によって得られる実質的な価値

ビジネス成果の向上と信頼構築

AI TRiSMの導入効果は、単なるリスク軽減にとどまりません。ガートナーの調査によれば、TRiSM管理を積極的に行う企業は、より多くのAIプロジェクトを本番稼働させ、実際のビジネス価値を引き出すことに成功しています。

これは「信頼」が生み出す好循環によるものです。AIシステムへの信頼が高まることで、経営層は積極的な投資判断を下しやすくなり、現場の従業員もAIツールを積極的に活用するようになります。結果として、AIによる業務効率化やイノベーション創出が加速します。

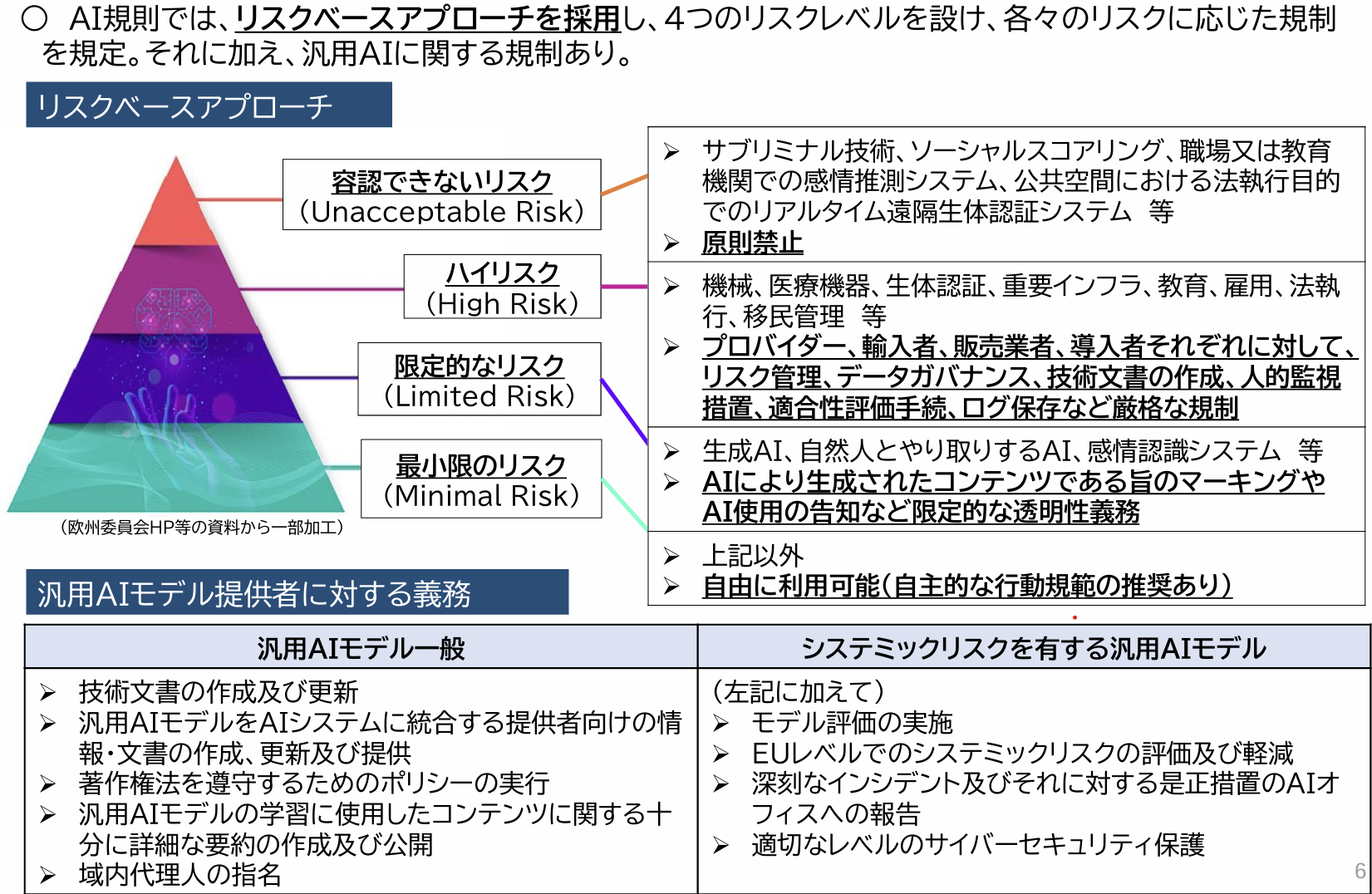

コンプライアンス対応と競争優位性

規制対応の観点からも、AI TRiSMは重要な役割を果たします。EUのAI規制法(AI Act)をはじめ、世界各国でAIに関する規制が強化される中、AI TRiSMの枠組みを導入しておけば、これらの規制要件にスムーズに対応できます。

さらに、「責任あるAI」を実践する企業としてのブランド価値向上も期待できます。特にESG投資が注目される現在、AIガバナンスの充実は投資家からの評価向上にもつながります。

導入における課題と対処法

もちろん、AI TRiSM導入には課題も存在します。導入コストや複雑さ、開発スピードへの影響などが懸念されることがあります。

しかし、これらの課題は段階的アプローチによって緩和できます。まずは高リスクのAIシステムから優先的に適用し、そこで得られた知見を基に徐々に適用範囲を広げていく方法が効果的です。また、自動化ツールの活用により、手動でのチェック作業を最小限に抑えることも重要です。

開発スピードへの影響については、初期段階では確かに追加の工数が発生しますが、長期的には品質向上による手戻りの削減や、インシデント対応コストの低減により、全体的な開発効率は向上します。

生成AI時代におけるAI TRiSMの新たな役割

LLMがもたらす特有のリスクへの対応

ChatGPTのような生成AIの登場により、AI TRiSMに新たな要素が加わっています。従来のAIとは異なり、生成AIは予測不可能な出力を生成する可能性があり、「ハルシネーション」や機密情報の漏洩といった特有のリスクを抱えています。

企業内でLLMを活用する際は、出力のレビュー体制や不適切内容のフィルタリング、機密データ入力の制限などを設ける必要があります。ある大手IT企業では、社内向けチャットボットに多層的なガードレールを実装し、業務に関係のない質問や不適切な要求を自動的にブロックする仕組みを構築しています。

プロンプトインジェクション対策の重要性

生成AIに特有のセキュリティリスクとして、「プロンプトインジェクション」があります。これは、悪意のある入力により、AIの動作を意図しない方向に誘導する攻撃手法です。

AI TRiSMの枠組みでは、入力検証とサンドボックス環境での事前テストを組み合わせることで、こうした攻撃を防御します。実際に、金融機関の顧客サポートAIでは、プロンプトインジェクション検知システムを導入し、不正な操作の試みを即座に検出・遮断しています。

エージェントAIのガバナンス

自律的に行動するエージェントAIの登場により、AI TRiSMはさらに複雑な課題に対応する必要が出てきています。エージェントが予期しない行動を取らないよう、明確なタスク境界と終了条件の設定が不可欠です。

興味深い取り組みとして、ある研究機関では「AIコンスティテューション」と呼ばれる、エージェントAIの行動原則を定義する手法を開発しています。これにより、エージェントが自律的に行動しながらも、組織の価値観や倫理基準から逸脱しないようコントロールすることが可能になります。

今後の展望:AI TRiSMが切り拓く未来

標準化の進展と相互運用性の向上

ISO/IEC 42001:2023のようなAIマネジメントシステム規格の登場により、AI TRiSMの標準化が進んでいます。今後は、異なる組織間でのAIガバナンス情報の共有や、サプライチェーン全体でのリスク管理が可能になると期待されています。

特に注目すべきは、「AIパスポート」のような概念です。AIモデルの開発履歴、テスト結果、リスク評価などを標準化されたフォーマットで記録し、組織間で安全に共有する仕組みが検討されています。

規制との協調による市場の健全化

世界各国でAI規制の整備が進む中、AI TRiSMは規制要件を満たすための実践的なフレームワークとして位置づけられています。規制当局とAI TRiSM実践企業の対話により、実効性のある規制と革新的なAI活用の両立が図られることが期待されます。

私見:AI TRiSMが企業文化に与える本質的な影響

AI TRiSMの導入を支援してきた経験から言えることは、これが単なる技術的なフレームワークではなく、組織文化の変革を促す触媒となるということです。

AIリスクに真摯に向き合うプロセスを通じて、組織は「技術と人間の協調」という本質的な課題に向き合うことになります。結果として、技術への過度な依存でも、逆に技術への過度な警戒でもない、バランスの取れた「AIリテラシー」が組織全体に醸成されていきます。

さらに重要なのは、AI TRiSMが促す「透明性の文化」です。AIの判断根拠を説明可能にし、リスクを可視化することで、組織内のコミュニケーションが活性化し、部門間の壁を越えた協力関係が生まれます。これは、DX推進における最大の障壁とされる「組織のサイロ化」を解消する効果も持っています。

AI TRiSMを起点とした持続可能なAI活用

AI TRiSMは、企業がAIの恩恵を最大限に享受しながら、リスクを適切に管理するための包括的なフレームワークです。その本質は、技術的な対策と組織的なガバナンスを統合し、AIシステムの信頼性・安全性・倫理性を継続的に確保することにあります。

導入には確かに初期投資と努力が必要ですが、長期的に見れば、ビジネス成果の向上、規制対応の円滑化、そして何より組織全体のAIリテラシー向上という大きな価値をもたらします。

今後、AIがビジネスの中核を担う時代において、AI TRiSMのような統合的なリスク管理アプローチは、企業の持続的成長を支える重要な基盤となるでしょう。まずは自社のAI活用状況を棚卸しすることから始め、段階的にAI TRiSMの考え方を組織に浸透させていくことをお勧めします。