オープンソースという選択がもたらす自由度

Continue.devは2023年6月に創業されたContinue Dev, Inc.によって開発され、Y Combinator(S23バッチ)の支援を受けています。CEOのTy DunnとCTOのNate Sestiは、開発者がAIアシスタントに依存せざるを得ない時代において、ベンダーロックインと透明性の欠如が最大の問題だと考えました。実はNate SestiがNASAで働いていたとき、機密性の高いコードをAIでサポートできなかった経験が、Continue.dev誕生のきっかけになっています。

Continue.devの中核となる価値提案は三つあります。第一に、完全なオープンソース化により、送信されるプロンプトやLLMの出力をすべて確認できる透明性です。第二に、OpenAI、Anthropic、Ollama、LM Studio、Groq、Azure OpenAIなど、あらゆるLLMプロバイダーとの互換性があります。第三に、ローカルモデルを使用した完全なオフライン動作により、コードが外部に一切送信されない真のプライバシー保護が実現されています。この設計思想は、「開発者は自動化されるのではなく、増幅されるべき(Amplified, Not Automated)」という同社のビジョンを反映しています。

プラットフォームはVS CodeとJetBrains IDEの両方に対応しており、IDEの拡張機能として動作します。さらに、コマンドラインインターフェースであるcnコマンドを提供し、ターミナルやCI/CDパイプラインでのAI活用も可能にしています。Apache 2.0ライセンスは商用利用を完全に許可しており、企業が独自の修正を加えても公開義務がないため、エンタープライズ環境での採用も進んでいます。

五つのコア機能が構成する開発ワークフロー

Continue.devは、開発者の日常的なコーディング作業を包括的にサポートする五つの主要機能を提供しています。

機能名 | 起動方法 | 主な用途 | 技術的特徴 | 推奨モデル |

|---|---|---|---|---|

Autocomplete(自動補完) | Tab キー | 入力中のリアルタイムコード提案 | デバウンシング機構、キャッシング機能、複数検索手法、後処理(特殊トークン除去、インデント修正、低品質フィルタリング) | Mistral Codestral、Ollama Qwen2.5-Coder 1.5B |

Edit Mode(編集モード) | Cmd+I(Mac)/ Ctrl+I(Windows/Linux) | ファイル内のコード直接修正 | インラインdiff表示、個別変更の承認・却下、ファイル全体をコンテキストとして自動包含 | - |

Chat Mode(チャットモード) | Cmd+L(VS Code)/ Cmd+J(JetBrains) | 対話型AIアシスタント | 選択コード、@メンション、現在ファイル、会話履歴をコンテキスト化、リアルタイムストリーミング応答 | - |

Agent Mode(エージェントモード) | Cmd/Ctrl + . | 自律的な変更実装とバグ修正 | ツールアクセス、三つの動作モード(Chat/Plan/Agent)、自動実行とコマンド実行 | - |

Background Agents(バックグラウンドエージェント) | CI/CDパイプラインでスケジュール | 継続的な自動化ワークフロー実行 | 自動チェック、イシュー作成、リリースノート生成 | - |

モジュラーアーキテクチャが実現する柔軟性

Continue.devの技術アーキテクチャは、メッセージパッシング方式の三層構造で設計されており、プラットフォーム間でのコード再利用を最大化しています。

アーキテクチャは「core ⇔ extension ⇔ gui」という構造を持ちます。CoreコンポーネントはTypeScriptで書かれたビジネスロジックを含み、IDE拡張機能間で再利用可能です。config.jsonやconfig.yamlの読み込み、モデルとのやり取り、プロトコルインターフェースの定義を担当します。モデル、コンテキストプロバイダー、システムメッセージ、スラッシュコマンドを設定します。

コンポーネント | 実装技術 | 主な責任 |

|---|---|---|

Extension(IDE固有) | ・VS Code: VS Code Extension API + Node.js | CoreとGUIのセットアップ、両者間のメッセージパッシング、IDE固有のUIとロジック処理、Core/GUIインタラクション用のIDEインターフェース実装 |

GUI | React(サイドバーwebview)+ Redux Toolkit | チャットインターフェースのレンダリング、チャットセッション状態の管理 |

自動補完システムは、検索と応答処理を組み合わせた複合AIシステムです。類似度検索を使用してコードベースからコンテキストを選択し、Language Server Protocolと統合して定義を取得し、最近編集されファイルをコンテキストに含め、リアルタイムで提案をストリーミングします。

エージェントモードのツールシステムは、JSON形式で名前と引数スキーマを持つツールとして定義されます。ネイティブなツール呼び出しAPIをサポートしますが、独自の「システムメッセージツール」というフォールバックアプローチも実装しています。これは、ツールをシステムメッセージ内のXML形式に変換し、モデルが構造化されたXMLツール呼び出しを生成し、Continueがそれを解析して実行するというものです。この仕組みにより、すべてのモデルで普遍的な互換性を確保しています。

コンテキストプロバイダーは、組み込みプロバイダー(@Files、@Docs、@Code、ターミナル出力、デバッガー変数)、カスタムサーバー用のHTTPコンテキストプロバイダー、Model Context Protocol(MCP)サーバー用のMCPコンテキストプロバイダー、API経由のカスタムコンテキストプロバイダーを提供します。

設定システムは二つのアプローチを提供します。Hub Agents(クラウド管理)は、hub.continue.devでクラウド管理された設定を提供し、マシン間での簡単なセットアップと同期、コミュニティエージェントの利用、集中型APIキー管理、チーム標準化が可能です。Local Agents(ファイルベース)は、config.yamlファイルによる完全な制御、バージョン管理統合、エアギャップ/オフライン機能、最大限のカスタマイズアクセスを提供します。

実際の開発ワークフローと統合パターン

Continue.devの実用性は、日常的な開発ワークフローへのシームレスな統合にあります。典型的な使用パターンを見ていきましょう。

コード補完ワークフローでは、開発者がコードを入力すると、デバウンス後に自動補完が提案を表示し、Tabキーで受け入れて次の行に進みます。明確な関数名、コメント、型注釈があると最も効果的に動作します。コンテキストは現在のファイルと最近の編集から自動的に収集されます。

クイックコード編集では、修正するコードを選択し、Cmd/Ctrl+Iで編集を起動し、「エラーハンドリングを追加」などの短い指示を入力します。インラインdiffで変更案を確認し、Cmd+Opt+Y / Cmd+Opt+Nで個別に承認・却下するか、Cmd+Shift+Enterですべてを受け入れます。小規模で的を絞った変更(リファクタリング、ドキュメント、バグ修正)に最適です。

インタラクティブな問題解決(チャット)では、問題のあるコードを選択し、Cmd/Ctrl+Lでチャットを開き、「なぜこの関数は遅いのか」と質問します。説明を確認し、「どうすれば最適化できるか」とフォローアップし、提案されたコードをボタン経由で適用してテストと反復を行います。

複雑な機能実装(エージェント)では、エージェントモードを開き(Cmd/Ctrl+.)、「JWTミドルウェアとルートで認証を追加」などの指示を提供します。エージェントはツール使用(read_file、edit_file、create_new_file)を提案し、ツール呼び出しを確認して承認し、エージェントが変更を実装します。diffを確認し、実装をテストして、必要に応じて反復します。デフォルトでは人間の監視が必要ですが、自動承認に設定することもできます。

自動化ワークフロー(CLI)では、対話型の複雑なタスクとしてTUIモードを使用します。cd project-directoryしてcnでTUIモードを開始し、@src/app.js 認証をOAuth2にリファクタリングと入力し、エージェントの計画を確認し、ツール呼び出しを承認して、変更をテストします。自動化タスクでは、cn -p "現在のgit変更に対する従来型コミットメッセージを生成"でコミットメッセージを生成したり、CI/CD自動化でcn --config org/code-reviewer -p "PR変更をレビュー" --autoを実行します。

コミュニティでは、Continue + Aiderの組み合わせが人気のワークフローとして報告されています。Aiderをターミナルで複雑な編集とマルチファイル変更に使用し、Continueはインラインの超シンプルな編集、コードについての議論のためのチャット、質問とレビューに使用します。ユーザーレビューによれば、「Continueは単独で3/5の評価だが、Aiderと組み合わせると4/5になる」とのことです。

開発者が得る実践的な利点

Continue.devが開発者にもたらす利点は、技術的な側面と経済的な側面の両方に及びます。

コスト効率は最も明確な利点です。GitHub Copilotの個人プランは月額10ドル、Cursorは月額20ドルですが、ContinueのコアIDE拡張機能は完全無料で、使用制限がありません。ユーザーは自分のAPIキーを持ち込み(BYOK: Bring Your Own Key)、LLMプロバイダーに直接支払うため、マークアップがありません。ローカルモデルを使用すれば、オープンソースモデルで完全に無料で実行できます。あるフィンテックスタートアップは、Continue.devのGPT-4統合を使用してコードレビュー時間を40%削減したと報告しています。

プライバシーと制御は、規制業界や機密性の高いプロジェクトにとって決定的な利点です。100%ローカル展開がOllamaやLM Studio経由で可能であり、コードが安全な環境外に出ることはありません。Continue.devは独自のサーバーを経由せず、ユーザーと選択したLLMプロバイダー間で直接通信が行われます。これはCursorとは対照的で、Cursorはカスタムモデルを使用する場合でも一部のリクエストをバックエンド経由でルーティングします。NASAの開発者は、日中はプライバシー上の懸念からLLMを使用できなかったが、Continueのローカルデプロイで解決できたと述べています。医療SaaS企業はHIPAAコンプライアンスのためにContinueを選択しました。

モデルの柔軟性により、開発者はタスクとコストに最適化できます。アーキテクチャ計画にClaude Opus 4.1、迅速な実装にClaude Sonnet、自動補完にCodestral(コスト効果的)、オフライン作業にローカルモデル(Qwen2.5-coder)を使用できます。異なるモデルを異なる役割(chat、edit、apply、autocomplete、embed、rerank)に設定可能で、これは市場で最も広範なモデルプロバイダーサポートです。

カスタマイズと拡張性は、技術的に高度なチームにとって大きな価値があります。JSON/YAML設定ファイルによりバージョン管理と共有が可能で、カスタムスラッシュコマンド、カスタムコンテキストプロバイダー、Model Context Protocol(MCP)ツール統合、.continuerulesスタイルの設定でプロジェクト固有のコーディング標準やアーキテクチャパターンを定義できます。開発者は必要に応じてContinueをフォークして修正することもできます。

透明性は、Continue.devがオープンソースであることから得られる独自の利点です。LLMに送信されるプロンプトをログで確認でき、モデルの出力を検査できます。「GitHub CopilotやCursorでプロンプトとLLM出力を検査してみてください」とあるレビュアーは述べています。この透明性により、デバッグが容易になり、プロンプトエンジニアリングを学べ、AIアシスタントがどのように機能するかを理解できます。

ベンダーロックインの回避は長期的な利点です。コードと設定はユーザーの管理下にとどまり、Apache 2.0ライセンスにより、商用利用、修正、配布が完全に許可されます。会社が変わっても、プロジェクトはコミュニティが継続できます。

克服すべき課題と現実的な制約

Continue.devには明確な利点がある一方で、開発者が認識すべき重要な制約と弱点も存在します。

コード生成品質は、最も一貫して指摘される弱点です。詳細なレビューを行った開発者は、「コアフィーチャーであるコーディングは平凡だ。最先端のモデルを使用しても、提案された編集に特に満足することはないだろう」と述べています。Continueのアプローチは「直接的で鈍重」と表現され、「Continueは、コンテキストに収まる周囲のコードの断片をLLMに投げつけ、コードの断片を挿入するように丁寧に依頼する...これはうまく機能しない」という指摘があります。インライン編集をリクエストした際に、プラグイン可能でないコードを受け取る事例が多数報告されています。比較では、Continueは3/5の評価に対し、Cursorは4.5/5と評価されています。「CursorやAiderが外科用器具のように見えるのに対し、Continueはまともなハンマーのように見える」という批判もあります。

安定性と信頼性の問題は、小規模チームと急速な開発ペースの結果です。拡張機能全体にバグがあり、「アプリは時々不安定で奇妙だ」という報告があります。自動補完機能が「時々動作しない」問題は以前から知られていますが、完全には解決されていません。CMD+Iが初回使用時に表示されるまで5-10秒かかることがあります。これらの問題を修正するには、再起動が必要になることがあります。

ユーザー体験/インターフェースの問題も指摘されています。「インラインチャットは不格好だ」「インラインエディターのUI/UXはひどい」という評価があります。承認・却下ボタンが小さく見づらいです。現在のファイルを手動で追加する必要があります(自動的には含まれません)。「Models」タブと「Providers」タブの区別が混乱を招きます。商用ツールと比較して、洗練度に明確なギャップがあります。

限定的な高度機能として、Cursorの「Composer」のようなマルチファイル編集機能がなく、洗練されたプロンプト戦略が欠けています。コードベース検索システムは動作しますが、CodyやCursorほど洗練されていません。Continueは自らこれを「非常に初期段階」の作業と認めており、精度測定のためのメトリクスを開発中です。

学習曲線と設定の複雑さも障壁となり得ます。一部のプロバイダー(Azure OpenAIなど)はJSON設定ファイルの手動編集が必要です。ドキュメントに機能に関するギャップ(helpful/unhelpfulボタンなど)があります。プラグアンドプレイの競合製品よりもセットアップが困難です。技術的に快適な開発者にとっては理想的ですが、初心者には適していない可能性があります。

プラットフォーム固有の問題として、WindowsでのMCPサーバーの問題、エージェントモードでのシェル環境の問題、vscode.dev(ブラウザベース)では動作しない(Node.jsモジュールが必要)、一部のLinuxシステムでのJetBrainsサインインの問題などが報告されています。

競合ツールとの詳細な位置づけ分析

AI支援コーディングツール市場は急速に進化しており、Continue.devは独自のニッチを開拓しながらも、強力な競合と対峙しています。

GitHub Copilot(Microsoft/OpenAI)は市場リーダーで、最も広く採用されているAIコーディングアシスタントです。個人10ドル/月、ビジネス19ドル/月、エンタープライズ39ドル/月で提供されます。優れたコード提案、優秀なコンテキスト認識、洗練されたユーザー体験、GitHubとの深い統合が強みですが、プロプライエタリでベンダーロックインがあり、プライバシー懸念(コードがクラウドに送信される)という弱点があります。

CursorはプレミアムAIネイティブコードエディタ(VS Codeのフォーク)で、プロ機能は月額20ドルです。最高クラスのインライン編集、完全なコードベース認識、マルチファイル編集、洗練されたプロンプトエンジニアリング、複雑なリファクタリング用の「Composer」機能が強みですが、価格が高く、オープンソースではなく、カスタムモデルを使用してもバックエンド経由で一部のリクエストをルーティングするという弱点があります。

Tabnineはプライバシー重視のエンタープライズソリューションで、無料ティアがあり、チーム/エンタープライズ向けの有料プランがあります。プライバシーファースト(許可ライセンスのみで訓練)、SOC-2準拠、オンプレミス/VPCデプロイ、強力なセキュリティコントロールが強みですが、限定的なRAG機能、ローカルモデルサポートなし、提供される機能の割に高価という弱点があります。

Codeiumは強力な機能を持つ無料の代替品で、個人向けは無制限で完全無料、エンタープライズティアは有料です。キャップなしの完全無料ティア、強力なコンテキスト認識、多言語サポート、自動補完+チャットが強みですが、登録が必要、GDPR非準拠、すべての操作でコンテキストが利用可能ではないという弱点があります。

Continue.devの差別化ポイントは明確です。オープンソースと透明性では、完全にオープンソース(Apache 2.0)で、LLMに送信されるプロンプトを検査でき、コミュニティ駆動で140人以上の貢献者がおり、ベンダーロックインがなく、コードと設定がユーザーの管理下にあります。これは、このレベルの機能を持つ唯一の主要なコーディングアシスタントです。

マルチモデル柔軟性では、OpenAI、Anthropic、Ollama、LM Studio、Together AI、Groq、Azure OpenAI、ローカルモデルなど、あらゆるLLMで動作します。タスクごとに異なるモデルを使用でき(例:自動補完に高速モデル、チャットに強力なモデル)、ユーザーが自分のAPIキーを提供してコストを管理します。完全にオフラインでOllama、LM Studioを使用して実行できます。市場で最も広範なモデルプロバイダーサポートであり、他のツールはこのレベルの柔軟性を提供していません。

プライバシーとセキュリティでは、ローカルモデルで完全にオフライン実行可能で、Cursorとは異なり、カスタムモデル使用時にサーバー経由でルーティングしません。開発データはデフォルトでローカルに保存され(.continue/dev_data)、セルフホスト、オンプレミス、VPCデプロイオプションがあります。真のエアギャップ開発でAIアシスタンスを可能にする唯一のツールです。

カスタマイズと拡張性では、JSON/YAMLベースの設定でバージョン管理と共有が可能、カスタムコンテキストプロバイダー、カスタムスラッシュコマンド、カスタムルールとプロンプト、MCPツール統合があり、開発者がフォークして修正できます。最もカスタマイズ可能なコーディングアシスタントです。

コストモデルでは、コアIDE拡張機能が無料で使用制限なし、ユーザーがLLMプロバイダーに直接支払い、マークアップなし、チーム向け集中管理のHubプライシング、ローカルモデルで完全無料実行可能です。最もコスト効果的なオプション、特に小規模チームにとって。

しかし、重大な弱点も存在します。コード生成品質は致命的な弱点で、単純なプロンプトエンジニアリングによる「鈍重なアプローチ」により、特に複雑なタスクで非プラグイン可能なコードを頻繁に生成します。tree-sitter統合、洗練されたdiffアルゴリズム、マルチファイル編集オーケストレーションのような高度な技術が欠けています。コーディングパフォーマンスでは3/5の評価に対し、Cursorは4.5/5です。

ユーザー体験/安定性の問題は中程度の弱点で、一部の機能は洗練されていますが他は半端で、インラインエディタが表示されるまで5-10秒かかり、承認・却下ボタンが小さく、Cursorほどエレガントではありません。バグ、インデックス作成の問題、コンテキストプロバイダーの失敗、統合の癖があります。商用ツールと比較して洗練度に明確なギャップがあります。

現実世界での使用事例とベストプラクティス

Continue.devは、特定のユースケースと開発シナリオで真価を発揮します。

プライバシー重視のプロジェクトでは、医療、金融、政府機関の業務など、データが安全な環境外に出てはならない場合に理想的です。Ollama経由のローカルモデルを使用し、データフローを完全に管理できます。医療SaaS企業はHIPAAコンプライアンスのためにContinue.devを選択したと報告しています。

コスト意識の高い開発では、個人開発者や小規模チーム、学生や学習者、オープンソース貢献者、サイドプロジェクトに最適です。GroqやCodestralの無料モデルを使用したContinueは、ゼロコストの代替品を提供します。人気の組み合わせは「Continue.dev(Codestralでの自動補完)+ Aider(チャットとエージェント)」です。

マルチ言語プロジェクトでは、Qwen2.5-coderが「強力な多言語理解」を持ち、言語とタスクに基づいてモデルを切り替え、プロジェクト要件ごとにカスタマイズできます。Qwen2は「codegemmaやgranite-codeよりもはるかに優れたパフォーマンス」を示したという報告があります。

実験と学習では、コスト障壁なしで異なるLLMを試し、プロンプトエンジニアリングを学び、AIコーディングアシスタントがどのように機能するかを理解し、ツール自体をフォークしてカスタマイズできます。リポジトリのクローンと実行に10-20分しかかからなかったという報告があります。

チーム標準化では、一貫したAIツールを望む組織、カスタムルールとガイドライン、集中型モデル管理に適しています。Siemensはチームにロールアウトしたと報告されています。

オフライン開発では、ある開発者は「毎日BARTに乗っており、地下区間をOllamaを使ったContinueのエージェントモードで生産的なコーディング時間に変えた」と述べています。人気の組み合わせは、VS Code + Continue + Ollama + Qwen2.5-coderです。

自動化されたPRレビューでは、Continue CLIを自動化ワークフローに使用し、PRレビュー用のGitHubワークフロー統合、イシュートリアージ用のバックグラウンドエージェントを活用します。「トリアージボットは初期イシュー応答の80%を処理する」という報告があります。

セキュリティとプライバシーの包括的考察

Continue.devのセキュリティモデルは、ローカルファースト設計に基づいています。コード処理はローカルまたはユーザー管理のLLMプロバイダー経由で行われ、独自のContinueサーバーがコードを処理することはありません。開発データはデフォルトでローカルマシンの.continue/dev_dataに保存されます。

エンタープライズ機能には、「透明な認証層」を持つ集中型APIキー管理が含まれ、チームメンバーは直接表示せずにAPIキーを使用できます。個人ユーザーの場合、APIキーはローカル設定ファイル(.continue/config.json)に保存されます。

Continueは、「致命的な三要素(Lethal Trifecta)」と呼ばれる重大なAIエージェントセキュリティ脅威に公に対処しています。これは研究者Simon Willisonによって名付けられた概念で、AIエージェントが(1)プライベートデータ/ファイルへのアクセス、(2)信頼できないコンテンツ(Web、ユーザー入力)を処理する能力、(3)外部通信のためのネットワーク接続を持つ場合、プロンプトインジェクション攻撃によって機密データが漏洩する脆弱性が生じるというものです。

Continue.devの多層防御アプローチには、データ漏洩の防止(PR #7293)として、画像をレンダリングしたりネットワークリクエストを行う前に明示的なユーザー承認を要求し、自動画像リクエストによる静かなデータ漏洩を防ぐことが含まれます。機密ファイルのブロック(PR #7302)として、.envファイル、秘密鍵、証明書をエージェントのファイル読み取り機能からフィルタリングし、悪意のあるプロンプトがあってもエージェントがこれらのファイルにアクセスできないようにします。高リスクコマンドのフラグ付け(PR #7421、#7531)として、危険なコマンド(例:rm -rf /)を検出し、警告付きでブロックまたは明示的な承認を要求します。

重要なコンテキストとして、Continueはプロンプトインジェクションが業界全体で進行中の課題であることを認めています。CodeRabbitの脆弱性(単一のPRが100万のリポジトリへの書き込みアクセスを持つRCEにエスカレート)を動機として参照しています。セキュリティは一度きりの修正ではなく、継続的なプロセスとして扱われています。

プライバシーポリシー(最終更新:2024年8月26日)によれば、オープンソースソフトウェアの使用に個人データは不要で、コードはローカルまたは選択したLLMプロバイダーにのみ送信されます。テレメトリはオプションで匿名化されており、ユーザー設定またはVS Code設定で無効化できます。PostHog(オープンソースプラットフォーム)を使用し、収集されるデータ(匿名化およびPII除去済み)には、提案の承認・却下(実際のコード/プロンプトではない)、使用されたモデルとコマンド名、生成されたトークン数、OSとIDE情報、一般的なページビュー統計が含まれます。実装コードはGitHub上で公開されています。

非オープンソース提供(Hub、エンタープライズ)を使用する場合、連絡先情報、職業情報、アカウント情報とトランザクション履歴、カスタマーコンテンツ(サービスにアップロードされたファイル/データ)、支払い情報(Stripe経由で処理され、Continueによって保持されない)が収集されます。

組織にとっての主要なプライバシー懸念は三つあります。第一に、LLMプロバイダーのデータ処理で、コードは設定したLLMプロバイダー(OpenAI、Anthropicなど)に送信され、彼らのプライバシーポリシーの対象となります。第二に、エンタープライズ機能で、Continue Hubやエンタープライズ機能を使用すると、データがContinueのインフラストラクチャを通過します。第三に、MCP統合で、Model Context Protocolツールがさまざまなデータソースにアクセスする可能性があり、MCPサーバープロバイダーへの信頼が必要です。

資金調達と持続可能性の展望

Continue Dev, Inc.は、総額510万ドルを調達しています。2023年後半の初期シード(約210万ドル)はHeavybit(開発者重視のVC)とY Combinator(S23バッチ)が主導しました。2025年2月の追加SAFE(300万ドル)もHeavybittが主導しました。SAFEは将来の株式のための簡易契約(遅延株式配分)を意味します。エンジェル投資家には、Julien Chaumond(Hugging Face共同創業者)、Lisha Li(Rosebud AI創業者)、Florian Leibert(Mesosphere共同創業者)が含まれます。

創業者は、CEO Ty Dunn(Rasaでの経歴、会話型AI)とCTO Nate Sesti(NASA、プライバシー重視の開発経験)です。チームは現在5名で、最近の資金調達で「少なくとも倍増」する計画を持ち、ソフトウェアエンジニアリング採用に注力しています。

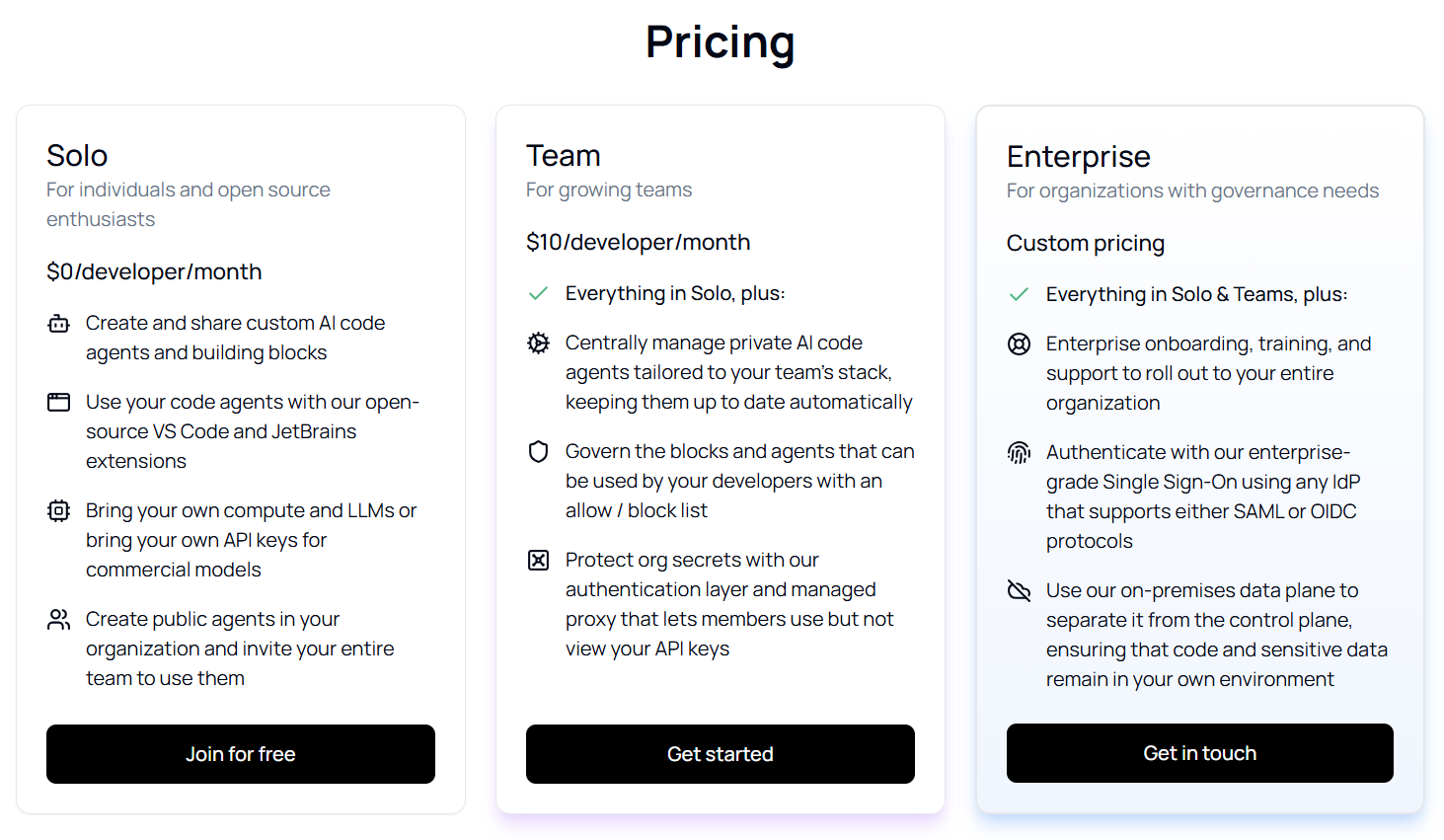

収益モデルは二つのアプローチを持ちます。オープンソースコア(無料)として、IDE拡張機能は無料でオープンソースのまま、DiscordとGitHub経由のコミュニティサポート、好意と配布を生成します。収益化パスとして、チームプラン(月額10ドル/ユーザーから)、エンタープライズプラン(カスタム価格、オンプレミスデータプレーン、SSO統合、集中ガバナンス、監査ログ、エンタープライズサポート)、将来の開発データエンジン(チームデータを使用した継続的なLLM改善のための計画された有料提供)があります。

持続可能性評価では、強みとして、強力なオープンソース配布(200万以上のダウンロード)が有料コンバージョンの大きなファネルを作成し、エンタープライズの関心(Siemensなどの大組織がすでに使用)があり、低いバーンレート(「非常に低コストを維持」戦略で、510万ドルがより長く持続)があり、戦略的ポジショニング(成長するAI開発ツール市場の初期、2023年に48億ドル、CAGR 23.2%)があり、質の高い投資家(Heavybittは開発ツールで強力な実績)がいます。

弱みとして、小規模チーム(5名の従業員は、十分な資金を持つ競合と比較して開発速度を制限)があり、控えめな資金調達(510万ドルは競合と比較して小規模で、Cursorは9桁の評価額の噂、Codeiumは1億ドル以上を調達、GitHub CopilotはMicrosoftの支援)があり、収益化の不確実性(「開発データエンジン」収益モデルは未実証)があり、競争の激しさ(潤沢な資金を持つ競争に直面)があります。

リスク要因として、買収される可能性(買収者によってプラスまたはマイナス)、追加の資金調達ラウンドが必要になる可能性、オープンソースは会社が苦戦した場合に機能がフォークされる可能性、LLMプロバイダーエコシステムの進化への依存があります。

緩和要因として、オープンソースの性質により、必要に応じてコミュニティがプロジェクトを継続できること、Apache 2.0ライセンスがコードの利用可能性を保証すること、低いインフラストラクチャコスト(ユーザーが自分のLLM APIを持ち込む)、強力なコミュニティの牽引力がプロダクトマーケットフィットを示唆していることがあります。

長期的な実行可能性の最も可能性の高いシナリオは、着実な成長(40%の確率)として、エンタープライズ顧客を獲得し、持続可能な20-50人のチームに成長し、「オープンソース代替品」カテゴリーのリーダーになること、買収(30%の確率)として、より大きな開発ツール会社に買収され、既存プラットフォームに統合され、条件が不利な場合はオープンソースコミュニティがフォークする可能性があること、追加資金調達(20%の確率)として、12-18ヶ月でシリーズA(1000万-2000万ドル)を調達し、開発と販売を加速し、資金を持つライバルとより直接的に競争すること、コミュニティ主導の移行(10%の確率)として、商業モデルが苦戦した場合、プロジェクトがコミュニティ維持になり、コアは継続するがエンタープライズ機能は停滞することです。

今後の展望と技術的進化

Continue 1.0は2025年2月にリリースされ、「自動化ではなく増幅(Amplified, Not Automated)」というビジョンを掲げています。開発者はAIによって置き換えられるのではなく、強化されるべきだという哲学です。オープンアーキテクチャにより、カスタマイズと相互運用性が可能になります。

1.0の主要機能には、ビルディングブロックシステムとして、Models、Rules、Context、Docs、Prompts、Data、MCPという7つの定義されたビルディングブロックがあり、ミックスアンドマッチのカスタマイズを可能にするモジュラーアプローチです。Continue Hub(hub.continue.dev)は、カスタムAIアシスタントを発見して共有するためのレジストリで、ブロック、ルール、設定のためのコミュニティ駆動のマーケットプレイスであり、「参加のアーキテクチャ」で簡単に貢献できます。Config.yaml標準化は、AIアシスタント設定の標準パッケージ形式で、セットアップの共有と複製を容易にし、パーサーは他のツールで使用するために分離されます。ツール間の互換性として、他のオープンAI開発ツール(Aider、Cursorなど)と連携し、より広範なオープンAI開発ツールエコシステムをサポートすることを目標としています。

最近出荷された機能には、Workflows(継続的に実行されるバックグラウンドエージェント)、Multi-file Edit(1つのインターフェースから複数のファイルを同時に編集)、Chat UIリフレッシュ(改善されたナビゲーション、固定入力、コードシンボルへのリンク)、Anthropicモデルでのツール(拡張されたツール使用機能)、Next Edit(Instinctモデル - 開発者をフロー状態に保つために次の編集を予測するオープンモデル)、Plan Mode(コーディング前のAI支援計画)、Agent Mode(自律的なマルチステップタスク実行)、CLI(cn - ターミナルワークフロー用のコマンドラインインターフェース)が含まれます。

新たな焦点領域として、Continuous AI Integrationでは、IDEを超えてターミナルとCI/CDパイプラインへ移行し、AIを開発インフラストラクチャの一部として扱い、DevOps採用と同様の軌跡を辿ります。コードベース検索の改善では、これが「非常に初期段階」の作業であることを認め、精度を測定するためのメトリクスを開発し、埋め込み最適化と多段階検索を探求しています。セキュリティ強化では、継続的な多層防御アプローチ、セキュリティを継続的なプロセスとして扱い、新たなAIエージェント脅威に対応しています。エンタープライズ機能では、オンプレミスデータプレーンデプロイメント、SSO統合(SAML、OIDC)、セキュリティコンプライアンスのためのクエリスキャン、包括的なアクティビティログ、集中ガバナンス(許可/ブロックリスト)を提供しています。

差別化戦略は、プロプライエタリな競合(Cursor、GitHub Copilot)に対するオープンソース、ローカルモデルを含むあらゆるLLMを使用するモデル柔軟性、「ハッカブル」で透明なカスタマイズの深さ、コードをローカルに保持するかプロバイダーを選択するプライバシー制御、ベンダーロックインなしという点にあります。

ターゲットセグメントは、完全なカスタマイズを持つ無料ティアの個人開発者、月額10ドルから始まる共有設定のチーム、連絡して価格を確認する完全なガバナンス、SSO、オンプレミスのエンタープライズです。

パートナーシップには、IBM(Granite 4モデル統合)、Together.ai(モデルホスティング)、Ollama(ローカルモデル)、Google、xAI、その他(モデルプロバイダー)、Anthropic、OpenAI(プレミアモデルサポート)が含まれます。]

実践的な意思決定ガイダンス

Continue.devを使用すべき場合は、コードを処理するLLMプロバイダーの完全な制御が必要な場合、プライバシーのためにローカル/セルフホストモデルを使用したい場合、オープンソースの透明性とハッカビリティを重視する場合、チームワークフローのための深いカスタマイズが必要な場合、ベンダーロックインを避けたい場合、設定と保守ができる技術チームがある場合、厳格なデータ居住要件を持つ組織で作業する場合(完全にローカルセットアップを使用可能)です。

代替案を検討すべき場合は、エンタープライズグレードの安定性とサポートをすぐに必要とする場合、設定とトラブルシューティングをする技術リソースがない場合、最小限のセットアップで成熟したすぐに使える体験が必要な場合、高度なRAG/コードベース理解が必要な場合(まだ成熟中)、自己保守のない完全に管理されたソリューションが必要な場合、LLMプロバイダーを精査する能力のない高度に規制された業界で働いている場合です。

採用前の重要なアクションとして、LLMプロバイダーを評価すること(セキュリティ/プライバシーは選択するLLMに大きく依存します)、安定性をテストすること(プレリリース版を試し、いくつかのバグを予期します)、プロンプトインジェクションリスクをレビューすること(「致命的な三要素」と緩和策を理解します)、サポートニーズを評価すること(無料ティアはコミュニティサポートのみ)、設定を計画すること(セットアップとカスタマイズの時間を予算化します)、使用状況を監視すること(LLM APIコストと使用パターンを追跡します)、ガバナンスを確立すること(チームにロールアウトする場合、承認されたモデル/ツールを定義します)があります。

結論:オープンソースAIツールの現在地

Continue.devは、開発者の自律性とプライバシーを尊重する原則に基づいて構築された、真に革新的なオープンソースAIコーディングアシスタントです。29,000以上のGitHubスター、300万回以上のダウンロード、Siemensのような大企業での採用という実績は、プロダクトマーケットフィットの強力な証拠です。

その最大の強みは、モデル柔軟性、プライバシー制御、カスタマイズの深さ、ベンダーロックインの回避という、他のツールが提供できない組み合わせにあります。完全にローカルで動作し、エアギャップ環境でAI支援コーディングを可能にする唯一の主要ツールとして、規制業界や機密性の高いプロジェクトにとって他に代わるものがない選択肢です。

同時に、コード生成品質、ユーザー体験の洗練度、安定性において、潤沢な資金を持つ競合(CursorやGitHub Copilot)に後れを取っていることも認識する必要があります。小規模チーム(5名)と控えめな資金調達(510万ドル)は、開発速度の制約となり得ます。ただし、オープンソースの性質とApache 2.0ライセンスにより、会社が困難に直面してもコミュニティがプロジェクトを継続できるという保証があります。

Continue.devは、プライバシーを重視する技術チーム、コスト意識の高い開発者、カスタマイズを重視する組織にとって最適な選択肢です。洗練度やすぐに使える体験よりも、制御と透明性を優先する開発者にとって、Continue.devは単なるツールではなく、ベンダーロックインに対する哲学的立場表明でもあります。

AI支援開発ツール市場がさらに進化する中、Continue.devのオープンで相互運用可能なアプローチは、エコシステム全体にとって重要な基盤となる可能性を秘めています。2025年2月にリリースされたContinue 1.0は、この方向への重要な一歩であり、今後2-3年間の持続可能性には中程度の自信を持つことができます。長期的な成功は、エンタープライズ収益の実行と、進化し続ける競争環境への適応にかかっています。