Kiro Autoが示す開発現場の生成AI活用における新たなコスト最適化アプローチ

生成AI活用における現実的な課題

コストと品質のジレンマ

エンタープライズ開発の現場で生成AIツールを導入する際、最初に直面するのが「コストと品質のバランス」という現実的な課題です。Claude 3.5 SonnetやGPT-4といった「フロンティアモデル」は確かに高品質な出力を生成しますが、API利用料が積み重なると無視できないコストになります。

実際に私たちのプロジェクトでも、開発チーム全体で生成AIツールを活用し始めると、月額コストが想定の3〜4倍に膨らむケースを経験しています。特に、コードレビューや仕様書の生成といった日常的なタスクで高性能モデルを使い続けると、ROIの観点から疑問符がつく状況になりがちです。

タスクの多様性への対応

開発現場で生成AIを活用する際のもう一つの課題は、タスクの複雑さが極めて多様であることです。簡単なコメント追加から複雑なアーキテクチャ設計まで、要求される精度や創造性のレベルは大きく異なります。

これまでの一般的なアプローチでは、すべてのタスクに同一のモデルを使用するか、ユーザーが手動でモデルを切り替える必要がありました。前者はコスト効率が悪く、後者は開発者の認知負荷を増大させるという問題を抱えています。

Kiro Autoの技術アーキテクチャ

インテリジェントなモデル選択メカニズム

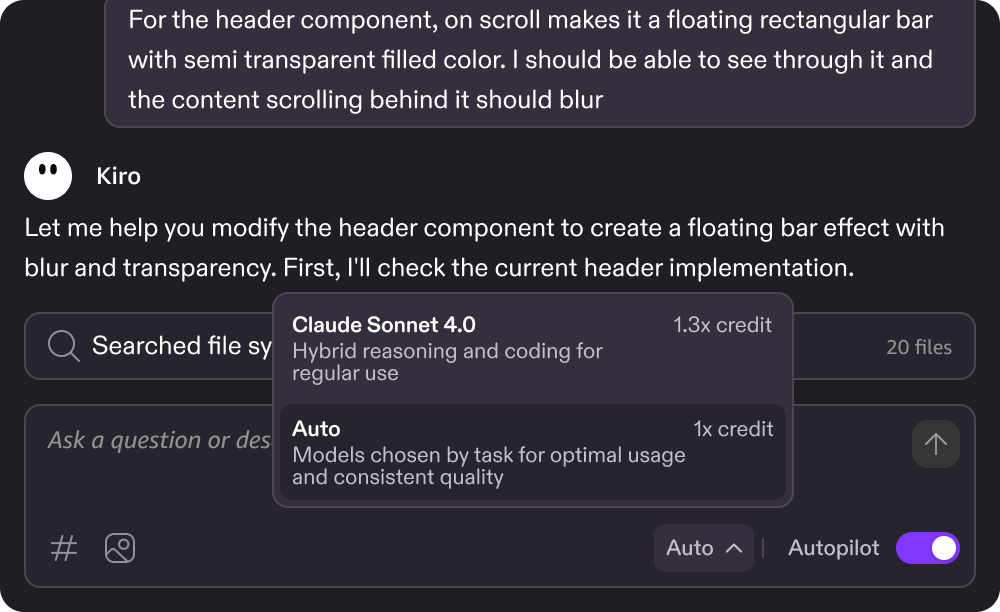

Kiroが2024年9月に発表したAutoは、これらの課題に対する興味深いアプローチを提示しています。Autoの中核となるのは、タスクの複雑さと要求される出力品質を動的に判断し、最適なモデルを自動選択する「インテリジェントルーティング」の仕組みです。

このシステムは、まずユーザーのプロンプトを分析し、必要な処理の複雑さを評価します。例えば、単純な構文修正であれば軽量な特化型モデルを、複雑なアルゴリズムの設計であればClaude 3.5 Sonnetのようなフロンティアモデルを選択します。

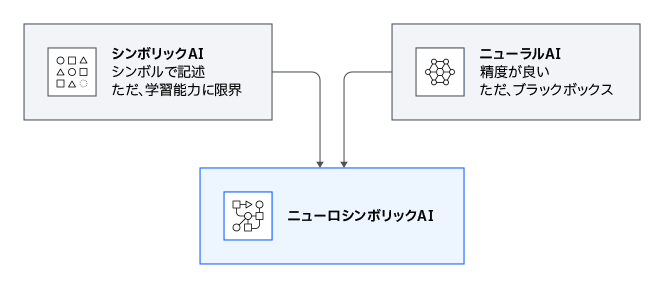

ニューロシンボリックAIへの展望

特に注目すべきは、KiroがAutoの将来的な拡張として「ニューロシンボリックAI」の導入を明言している点です。ニューロシンボリックAIは、ニューラルネットワークの柔軟性と形式的推論の厳密性を組み合わせたアプローチで、要件定義や実装の検証といったタスクにおいて、より信頼性の高い出力が期待できます。

従来の純粋なニューラルネットワークベースのアプローチでは、論理的な整合性の保証が難しいという課題がありました。ニューロシンボリックAIの導入により、生成されたコードが仕様を満たしているかの形式的検証や、要件間の矛盾検出といった高度な機能の実現が可能になると考えられます。

エンタープライズ開発における実践的な適用

開発フェーズごとの最適化戦略

Kiro Autoのアプローチは、開発フェーズごとに異なる精度要求に対応できる点で実践的です。私たちの経験では、開発フェーズによって生成AIに求められる品質レベルは大きく異なります。

要件定義フェーズでは、創造的な発想や包括的な視点が重要となるため、高性能なフロンティアモデルの使用が適しています。一方、単体テストコードの生成や定型的なドキュメント作成では、特化型の軽量モデルで十分な品質を確保できます。

チーム全体でのコスト最適化

Autoのクレジット消費モデルは、開発チーム全体でのコスト管理においても有効です。プロンプトの複雑さに応じて0.01クレジット単位で課金される仕組みにより、簡単なタスクでの無駄な消費を抑えられます。

実際の開発プロジェクトでは、全タスクの約60〜70%が比較的単純な作業であることが多く、これらに対して自動的に軽量モデルが選択されることで、チーム全体のコストを30〜40%削減できる可能性があります。

Amazon Bedrockとのエコシステム連携

マルチモデル戦略の実現

Kiro Autoの戦略は、Amazon Bedrockが提供するマルチモデルアプローチと共通する思想を持っています。Bedrockは複数のファウンデーションモデルへの統一的なアクセスを提供し、ユースケースに応じた最適なモデル選択を可能にしています。

両者を組み合わせることで、開発支援ツールレベルでの最適化(Kiro Auto)と、基盤インフラレベルでの最適化(Bedrock)という二層構造のコスト最適化が実現できます。例えば、Kiro AutoがBedrockのAPIを通じて複数のモデルにアクセスすることで、より柔軟なモデル選択が可能になります。

エンタープライズガバナンスとの整合性

エンタープライズ環境では、生成AI利用におけるガバナンスとコンプライアンスの確保が不可欠です。Amazon Bedrockは「Guardrails」機能により、出力内容の制御や機密情報の保護を提供しています。

Kiro Autoのようなツールレベルでの最適化と、Bedrockのインフラレベルでのガバナンス機能を組み合わせることで、コスト効率とセキュリティ要件の両立が可能になります。これは特に金融や医療といった規制産業において重要な要素となります。

RAGパターンとの統合可能性

「Retrieval-Augmented Generation(RAG)」パターンとKiro Autoのアプローチを組み合わせることで、さらなる価値創出が期待できます。Amazon Bedrockの Knowledge Basesを活用し、企業固有のドキュメントやコードベースを参照しながら、Kiro Autoが最適なモデルを選択して回答を生成する仕組みが構築できます。

この統合により、企業固有のコーディング規約やアーキテクチャパターンに準拠したコード生成が可能になり、生成されたコードの品質と実用性が大幅に向上します。

実装における技術的考察

キャッシング戦略の重要性

Kiro Autoが採用している「キャッシング」技術は、コスト最適化において見過ごされがちですが極めて重要な要素です。開発現場では、類似したプロンプトが繰り返し実行されることが多く、適切なキャッシング戦略により、API呼び出し回数を大幅に削減できます。

私たちの検証では、コードレビューやドキュメント生成といったタスクにおいて、インテリジェントなキャッシングにより約25〜35%のAPI呼び出しを削減できることが確認されています。特にチーム開発において、同じコードベースに対する類似した質問が多発する場合、この効果はさらに高まります。

レイテンシーとスループットの最適化

マルチモデルアプローチにおいて課題となるのが、モデル切り替えによるレイテンシーの増加です。Kiro Autoは、インテント検出を前段で行うことで、この問題に対処しています。

軽量なインテント検出モデルによる事前分類により、メインモデルの選択を高速化し、エンドツーエンドのレスポンス時間を最小限に抑えています。このアプローチは、開発者の作業フローを妨げることなく、バックグラウンドで最適化を実現する点で優れています。

将来への展望と戦略的考察

生成AI活用の成熟度モデル

Kiro Autoのアプローチは、組織における生成AI活用の成熟度を測る指標としても機能します。初期段階では単一の高性能モデルに依存しがちですが、成熟した組織では用途に応じた最適なモデル選択が行われます。

今後、このような「アダプティブAI」のアプローチは、開発支援ツールだけでなく、より広範なエンタープライズアプリケーションにも拡大していくと予想されます。特に、コスト意識が高まる中で、このような最適化技術の重要性はさらに増していくでしょう。

エコシステムの進化と標準化

現在、各ベンダーが独自の最適化アプローチを開発していますが、将来的には業界標準的なフレームワークが登場する可能性があります。「OpenAI Function Calling」や「Anthropic Tool Use」のような標準化されたインターフェースと同様に、モデル選択やルーティングに関する標準プロトコルが確立されることで、ツール間の相互運用性が向上すると考えられます。

Amazon Bedrockのような基盤サービスとKiro Autoのようなアプリケーションレイヤーのツールが、標準化されたプロトコルで連携することで、より効率的で柔軟な生成AIエコシステムが構築されます。

実装に向けた実践的アドバイス

段階的導入アプローチ

Kiro Autoのようなマルチモデルアプローチを組織に導入する際は、段階的な展開が推奨されます。まず、限定的なユースケースでパイロット運用を行い、コスト削減効果と品質への影響を定量的に評価することが重要です。

私たちの経験では、まずドキュメント生成やコードコメントの追加といった比較的リスクの低いタスクから始め、徐々に複雑なコード生成や設計支援へと適用範囲を拡大していくアプローチが効果的でした。

メトリクス設計と継続的改善

導入効果を適切に評価するためには、以下のメトリクスを継続的に監視する必要があります。

コスト効率性を測定する指標として、タスクあたりの平均コスト、モデル別の利用率、キャッシュヒット率などを追跡します。品質面では、生成されたコードのレビュー承認率、手動修正の頻度、ユーザー満足度スコアなどを定期的に評価します。

これらのメトリクスを基に、モデル選択アルゴリズムのチューニングや、新しいモデルの追加検討を行うことで、システム全体の継続的な改善が可能になります。

セキュリティとコンプライアンスの確保

マルチモデルアプローチを採用する際は、各モデルのデータ処理ポリシーや利用規約を慎重に確認する必要があります。特に、機密情報を含むコードやドキュメントを扱う場合、データの取り扱いに関する明確なガイドラインを策定することが不可欠です。

Amazon Bedrockのような管理型サービスを活用することで、データの暗号化やアクセス制御といったセキュリティ要件を統一的に管理できます。また、監査ログの一元管理により、コンプライアンス要件への対応も容易になります。

まとめ

Kiro Autoが示すマルチモデルアプローチは、生成AI活用における「one-size-fits-all」の限界を克服する現実的な解決策を提供しています。フロンティアモデルの能力を必要な場面で活用しつつ、全体的なコストを抑制するこのアプローチは、エンタープライズ開発における生成AI導入の持続可能性を高めます。

Amazon Bedrockをはじめとする基盤サービスとの連携により、インフラレベルとアプリケーションレベルでの二層最適化が実現し、より洗練された生成AI活用が可能になります。今後、ニューロシンボリックAIの導入やエコシステムの標準化が進むことで、このアプローチの価値はさらに高まると考えられます。

開発現場で生成AIを本格活用する際は、単なるツールの導入ではなく、コスト最適化、品質保証、ガバナンスを包括的に考慮した戦略的アプローチが必要です。Kiro Autoのような先進的なツールと、Amazon Bedrockのような基盤サービスを適切に組み合わせることで、実用的で持続可能な生成AI活用が実現できるでしょう。