高速フロンティアモデルという新しい概念

AIモデルの進化を追いかけていると、時折「これは単なる性能向上ではない」と感じる瞬間があります。Claude 4.5 Haikuは、まさにそうした転換点を示すモデルです。

従来、AIモデルは「Haiku(速度重視)」「Sonnet(バランス型)」「Opus(最高性能)」という明確な階層構造で提供されてきました。この構造は分かりやすく、用途に応じた選択が容易でした。しかし、Claude 4.5 Haikuは前世代の上位モデルである「Claude Sonnet 4」に匹敵する性能を、Haikuの価格帯と処理速度で実現しています。

Anthropic社の公式発表によれば、このモデルは特にコーディングやエージェント型のタスクにおいて、従来の上位モデルと同等かそれ以上の能力を発揮します。これは「速度」と「性能」という、これまでトレードオフの関係にあった要素の境界線を曖昧にする出来事です。

Anthropicはこのモデルを「高速フロンティアモデル」と位置付けています。フロンティア(最先端)という言葉が示すように、もはや高い性能を得るために高コストや長い待ち時間を許容する必要はない、という市場への明確なメッセージです。

エージェント型システムの実現に向けた設計思想

Claude 4.5 Haikuを理解する上で最も重要なのは、このモデルが単体での利用だけでなく、より大きなシステムの一部として機能することを前提に設計されている点です。

現代のAI活用において、複雑な問題を解決するには「分割統治」のアプローチが有効です。具体的には、まず高性能なモデルが問題を分析し、複数の小さなタスクに分解します。そして、分解された各タスクを複数の軽量モデルが並列で処理することで、全体の処理時間を大幅に短縮できます。

この構造において、Claude 4.5 Haikuは理想的な「実行役」として設計されています。上位モデルの「Claude Sonnet 4.5」が戦略を立て、複数のHaiku 4.5インスタンスが実際の作業を担当する、という協調的なワークフローが想定されているのです。

例えば、大規模なコードベースのリファクタリングを考えてみましょう。Sonnet 4.5がコード全体を分析して修正計画を立案し、10個の独立したファイルを特定したとします。次に、10体のHaiku 4.5エージェントが生成され、それぞれが1つのファイルを担当します。すべての作業が完了した後、Sonnet 4.5が結果を集約して最終確認を行います。

このアプローチは、単一の巨大なモデルを使い続ける「垂直スケーリング」ではなく、多数の効率的なモデルを並列活用する「水平スケーリング」という考え方です。これは、コスト面でも計算資源の面でも、より持続可能な方向性を示しています。

技術的な特徴と革新性

ハイブリッド推論モードの導入

Claude 4.5 Haikuには、Haikuファミリーとして初めて「ハイブリッド推論」という機能が実装されています。これは、Claude 3.7 Sonnetで導入された概念を継承・発展させたものです。

このモデルは2つの動作モードを持っています。デフォルトでは高速な応答を優先する「標準モード」で動作しますが、開発者はAPIを通じて「拡張思考モード」を有効にできます。拡張思考モードでは、応答を生成する前により多くの計算リソースを使って深く考えることができます。

この機能の価値は、タスクの複雑さに応じて動的に速度と品質をトレードオフできる点にあります。従来は、タスクの難易度に応じて異なるモデルエンドポイントにルーティングするロジックを実装する必要がありましたが、Haiku 4.5では単一のモデルで両方のニーズに対応できます。

さらに、拡張思考モードではモデルの「思考プロセス」を可視化できる場合があります。これは、AIエージェントのデバッグや、判断根拠に対する信頼構築において非常に重要な要素です。

コンテキスト認識トレーニング

Haiku 4.5の開発において、Anthropicは興味深い工夫を施しています。それが「コンテキスト認識トレーニング」です。

AIエージェントを長時間のタスクに使用していると、途中で作業を放棄したり、不完全な回答を生成したりする「エージェントの怠慢」と呼ばれる現象が発生することがあります。これは、モデルが自身のコンテキストウィンドウの使用状況を認識していないために起こる問題です。

Haiku 4.5では、モデルが自身のコンテキスト残量を認識するようトレーニングされています。コンテキストに余裕がある場合は粘り強く推論を続け、残量が少ない場合は適切に回答を締めくくるよう学習しているのです。

この改善は、単にモデルを大規模化するのではなく、観測された特定の失敗モードに対して外科手術的に介入するという、トレーニング哲学の進化を示しています。これにより、Haiku 4.5は本番環境での持続的な運用に耐えうる、より信頼性の高いモデルとなっています。

ビジョン機能とマルチモーダル対応

Haiku 4.5はテキストだけでなく、画像やグラフ、技術図面などの視覚情報も処理できます。この機能はClaude 3ファミリーから継承されたものですが、企業環境では極めて重要です。

財務報告書のグラフを解釈したり、スキャンされた文書から情報を抽出したり、製品の写真から特徴を特定したりするなど、実務では視覚データを含むタスクが頻繁に発生します。このマルチモーダル性により、Haiku 4.5は単なるテキスト処理ツールを超えた、汎用性の高いビジネスインテリジェンスツールとして機能します。

性能指標から見る実力

コーディング能力の実証

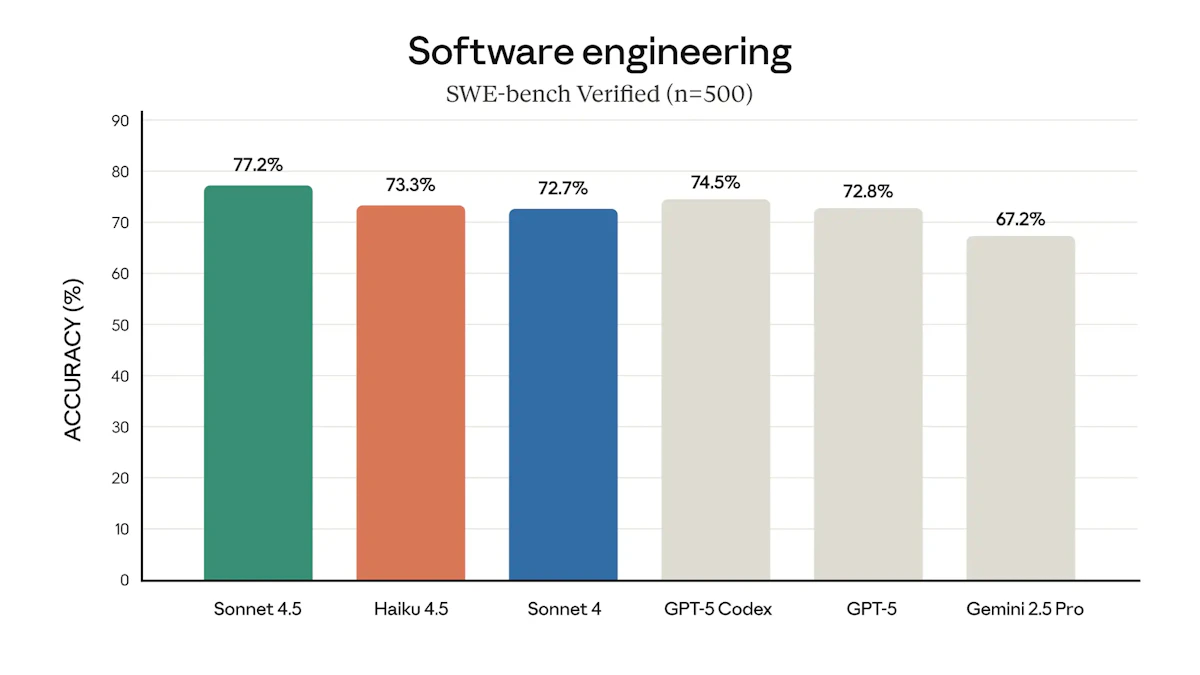

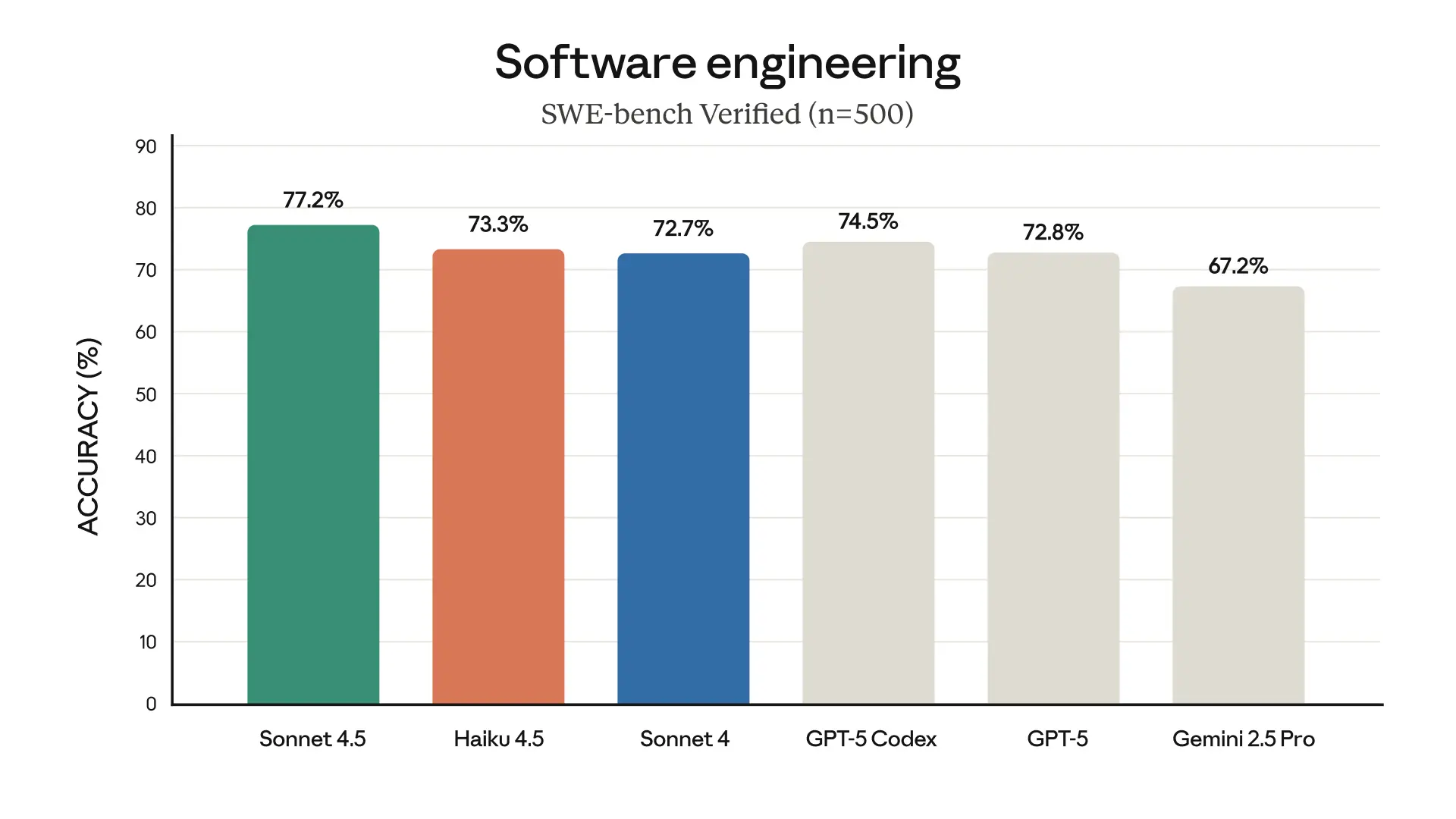

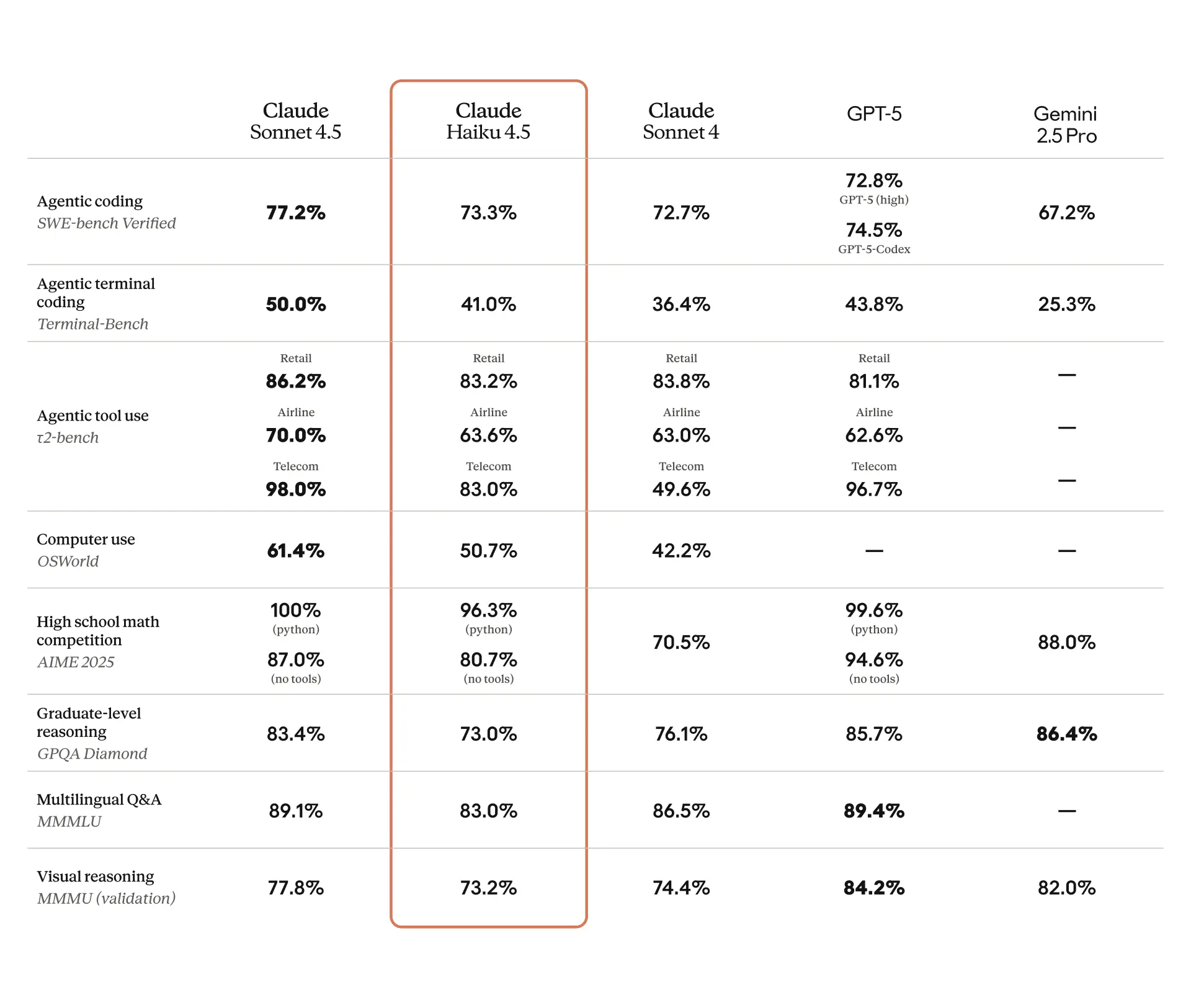

Claude 4.5 Haikuの性能を測る上で最も注目すべき指標が、「SWE-bench Verified」での73.3%というスコアです。このベンチマークは、GitHub上の実際の問題解決能力をテストする難易度の高いものです。

このスコアは、Haiku 4.5を世界トップクラスのコーディングモデルの一つとして位置付けるものであり、前世代の上位モデルであるSonnet 4に匹敵するという主張を強力に裏付けています。

Anthropicの公式発表では、SWE-benchのスコアが一貫して強調される一方で、MMLUのような伝統的な知識ベースのベンチマークはあまり前面に出されていません。これは、このモデルの主要な戦場がエージェント型タスクとコーディングにあることを示しています。

圧倒的な処理速度

ベンチマークスコア以上に実務で重要となるのが、実際の応答速度です。この点において、Haiku 4.5は驚異的な性能を発揮します。

初期のユーザー評価では、コーディングタスクにおいて毎秒約220トークンという速度が報告されています。これは比較対象となる多くのモデルの「ほぼ2倍」に達する速度です。あるケースでは「Windowsの描画が追いつかないほど速くテキストがスクロールした」と表現されるほどでした。

この速度は、開発者が思考を中断されることなくコーディングを続けられる「フロー状態」を維持することを可能にします。対話型AIにとっては、人間との対話に近い自然で即時的な応答を実現します。上位モデルのSonnet 4.5と比較しても最大4~5倍高速に動作するという報告があり、複数インスタンスを並列実行する用途では決定的な利点となります。

コストパフォーマンスの分析

価格設定の妙

Claude 4.5 Haikuの価格は、100万トークンあたり入力が1ドル、出力が5ドルです。直接の前身であるClaude 3.5 Haiku(入力0.80ドル、出力4ドル)から若干上昇していますが、その価値提案は価格の安さではありません。

重要なのは、前世代の上位モデルに匹敵する性能をこの価格帯で実現したという、卓越した「性能対コスト比」です。特にターゲット領域であるコーディングやエージェントタスクにおいては、他の追随を許さない価値を提供します。

隠れたコスト削減要素

総所有コストを評価する上で、見落としてはならない機能がいくつかあります。

まず「バッチ処理」機能です。大規模なデータ処理など、非同期での一括処理に対しては50%の割引が適用されます。定期的なレポート生成やデータクレンジングといったタスクのコストを大幅に削減できます。

次に「プロンプトキャッシング」です。同じプロンプトが繰り返し使用されるアプリケーションにおいて、キャッシュからの読み出しは基本入力価格のわずか10%(Haiku 4.5の場合0.10ドル/100万トークン)で済みます。定型的なクエリを扱うシステムでは極めて有効な機能です。

精度がもたらす経済的便益

コストを考える上で、見過ごされがちな要素があります。それが「精度」です。

ユーザー評価によれば、Haiku 4.5は他のモデルよりも「コード修正において遥かに精度が高い」という報告があります。これは、タスクに無関係なコードをコンテキストに含めることが少ないことを意味します。

複数ターンにわたる対話型のコーディングセッションでは、コンテキストに含まれるトークン量がAPIコストに直接影響します。精度が低いモデルは、ターンを重ねるごとに不要なトークンを蓄積し、コストを増大させます。一方、タスクに集中して簡潔な応答を生成するモデルは、同じタスクをより少ない総トークン数で達成できます。

したがって、トークン単価が同じ競合モデルが存在したとしても、実際の運用コストは異なる可能性があります。総所有コストは「価格×トークン数」だけでなく、「価格×アーキテクチャ効率」によっても決まるのです。

以下の表は、主要モデルのコストと性能を比較したものです。

表 主要モデルのコストパフォーマンス比較

モデル | 入力価格($/100万トークン) | 出力価格($/100万トークン) | SWE-benchスコア | 性能ポイント/ドル |

|---|---|---|---|---|

Claude 4.5 Haiku | $1.00 | $5.00 | 73.3% | 24.43 |

Claude Sonnet 4.5 | $3.00 | $15.00 | 77.2% | 8.58 |

GPT-4o mini | $0.15 | $0.60 | 未公開 | 未公開 |

Gemini 1.5 Flash | $0.075 | $0.30 | 未公開 | 未公開 |

性能ポイント/ドルは、SWE-benchスコアを平均価格で割った値です。この指標から、Haiku 4.5がコーディングタスクにおいて優れたコスト効率を実現していることが分かります。

実践的なユースケース

リアルタイム対話型アプリケーション

カスタマーサービスのチャットボットや対話型のペアプログラミングアシスタントなど、レイテンシがユーザーエクスペリエンスを直接左右するアプリケーションにおいて、Haiku 4.5の高速性は大きな価値を持ちます。

毎秒200トークンを超えるスループットにより、ユーザーはAIからの応答を待つストレスから解放されます。人間同士の対話に近い流動的で自然なインタラクションが実現し、顧客満足度や開発者の生産性を大幅に向上させることができます。

大規模展開でのコスト最適化

コンシューマー向けアプリケーションの無料プランにAI機能を提供する場合や、膨大な量の非構造化データを処理する場合、運用コストは重要な検討事項となります。

100万トークンあたり1ドル/5ドルという低価格により、大規模なユーザーベースに対してAI機能を提供しても、運用コストを許容範囲内に抑えることが可能になります。これにより、これまでコスト面で見送られてきたAIの民主化が加速します。

高スループット分析とリサーチ

金融分析システムで数千のリアルタイムデータストリームを監視する場合や、数十の学術論文を同時に読み込んで知見を統合する場合など、広範かつ大量のデータを扱うタスクに最適です。

その速度とサブエージェント・パラダイムによる並列処理能力は、単一の巨大モデルが逐次的に処理するには時間やコストがかかりすぎるようなタスクを、経済的に実現可能にします。

ソフトウェア開発の加速

複数のファイルにまたがる複雑なコードのリファクタリングや、レガシーシステムから新システムへの自動コード移行など、高度な開発タスクにおいても威力を発揮します。

SWE-benchでの高スコアが示す確かな能力と、ユーザー評価が裏付ける速度および精度により、開発者の生産性を摩擦なく向上させる実用的なツールとなります。特に、サブエージェントとして機能させることで、テストの自動生成、コード修正、ドキュメント更新といった一連のタスクを並列で実行させ、開発ライフサイクル全体を加速させることが可能です。

安全性とガバナンスへの配慮

エンタープライズ環境、特に規制の厳しい業界においてAIを導入する際、モデルの安全性とガバナンスは技術性能と同等かそれ以上に重要です。

AI安全性レベル2の位置付け

Haiku 4.5は、Anthropic独自の責任あるスケーリングポリシーに基づき、「AI安全性レベル2(ASL-2)」としてリリースされています。これは、より強力なモデルに適用される制限的なASL-3よりも低いレベルです。

この分類は広範な安全性評価に基づいており、特に化学・生物・放射線・核兵器の製造といった危険な領域における悪用リスクが限定的であると判断されました。

企業にとって、ASL-2として分類されたモデルを導入することは、リスク管理の観点から利点となります。モデル開発元によって壊滅的な誤用の能力が低いと事前に評価されているため、社内のガバナンスやコンプライアンスのプロセスを簡素化でき、承認プロセスの迅速化と市場投入までの時間短縮が可能になります。

定量的に証明された安全性

自動化されたアライメント評価において、Haiku 4.5はSonnet 4.5やOpus 4.1といった上位モデルと比較して、「統計的に有意に低い、アライメントから外れた行動の全体発生率」を示しました。

顧客対応アプリケーションや自律型エージェントにおいて、システムの信頼性と予測可能性は最優先事項です。有害、偏見、あるいは単に無意味なコンテンツを生成する確率が低いことは、ブランドリスクの低減、顧客体験の向上、運用上の手戻りの削減に直結します。

この定量的に証明された高いアライメント性能は、Haiku 4.5を本番システムで利用する際の信頼性の高い選択肢として位置付けています。

導入を検討する際の判断基準

Haiku 4.5を選択すべきケース

Claude 4.5 Haikuの導入を検討すべき状況を整理すると、以下のようになります。

レイテンシが最重要課題である場合です。リアルタイムの対話型ユーザーエクスペリエンスを提供するアプリケーションでは、その圧倒的な処理速度が大きな価値を持ちます。

タスクが並列化可能である場合も有力な選択肢となります。コーディング、リサーチ、データ分析など、サブタスクに分解できる複雑な問題において、複数のHaiku 4.5インスタンスを並列実行することで全体の処理時間を劇的に短縮できます。

大規模展開時のコストが主要な決定要因である場合、その優れた性能対コスト比が活きてきます。大規模なユーザーベースへの機能提供や、膨大なデータセットの処理において、運用コストを抑えながら高い性能を実現できます。

主要なドメインがコーディングやエージェント的なツール利用である場合、このモデルはこれらのタスクに特化して最適化されているため、最適な選択肢となります。

上位モデルを検討すべきケース

一方で、Claude Sonnet 4.5のような上位モデルを検討すべき状況もあります。

タスクが高度な戦略的計画、複雑な多段階推論、あるいは他のエージェントの指揮を必要とする場合です。このような「プランナー」や「オーケストレーター」としての役割には、より高度な推論能力が求められます。

単一の複雑なタスクにおける最高性能が、速度やコストよりも優先される場合も、上位モデルの出番です。

実装への道筋

段階的な導入アプローチ

Haiku 4.5の導入は、段階的に進めることをお勧めします。

第一段階として、既存のアプリケーションにおいて旧世代のモデルの「代替品」としてHaiku 4.5を使用します。これにより、性能とコストの改善効果を即座に測定し、導入のROIを評価できます。

第二段階では、新規プロジェクトにおいてサブエージェント・パラダイムを前提としたシステム設計を行います。計画と指揮にはSonnet 4.5を、並列実行にはHaiku 4.5を活用する協調的なアーキテクチャを構築します。Amazon BedrockやGoogle Cloud Vertex AIといったプラットフォームを活用することで、スケーラブルな展開が可能になります。

第三段階では、バッチ処理やプロンプトキャッシングといった高度なコスト削減策を実装します。特定の専門タスクに対しては、独自データを用いてモデルをファインチューニングすることも検討できます。

並列関数呼び出しの活用

Haiku 4.5の真価を引き出すためには、その「並列関数呼び出し」機能を理解することが重要です。

この機能により、単一の推論ステップ内で外部ツールへの複数のAPIコールを同時に発行できます。例えば、3つの異なるAPIから情報を取得する必要があるタスクにおいて、従来の逐次実行では完了までに時間1+時間2+時間3がかかりますが、並列実行では最大値(時間1、時間2、時間3)で済みます。

開発者はAPIを介してモデルが利用できるツールとそのスキーマを定義することで、データベース、計算機、Web検索機能などの外部システムとモデルを連携させることができます。この柔軟な統合能力が、Haiku 4.5を単なるテキスト生成器から、実世界と相互作用できる能動的なエージェントへと変貌させます。

以下は、並列ツール呼び出しを実装する際の基本的なパターンです。

interface ToolDefinition {

name: string;

description: string;

input_schema: {

type: "object";

properties: Record<string, any>;

required: string[];

};

}

interface ParallelToolCall {

tool_name: string;

tool_input: Record<string, any>;

}

async function executeParallelTools(

model: string,

prompt: string,

tools: ToolDefinition[]

): Promise<any> {

const response = await fetch('https://api.anthropic.com/v1/messages', {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'x-api-key': process.env.ANTHROPIC_API_KEY,

'anthropic-version': '2023-06-01'

},

body: JSON.stringify({

model: model,

max_tokens: 4096,

tools: tools,

messages: [

{

role: 'user',

content: prompt

}

]

})

});

const data = await response.json();

// モデルが並列にツールを呼び出す場合、複数のtool_useブロックが返される

const toolCalls = data.content.filter(

(block: any) => block.type === 'tool_use'

);

// すべてのツール呼び出しを並列実行

const results = await Promise.all(

toolCalls.map((call: any) =>

executeToolFunction(call.name, call.input)

)

);

return results;

}

async function executeToolFunction(

toolName: string,

input: Record<string, any>

): Promise<any> {

// 実際のツール実装をここに記述

// データベースクエリ、API呼び出し、計算処理など

switch (toolName) {

case 'database_query':

return await queryDatabase(input);

case 'api_fetch':

return await fetchFromAPI(input);

case 'calculation':

return await performCalculation(input);

default:

throw new Error(`Unknown tool: ${toolName}`);

}

}このコードは、複数のツールを定義し、モデルがそれらを並列で呼び出せるようにする基本的な実装を示しています。実際のプロダクションでは、エラーハンドリング、リトライロジック、タイムアウト処理などを追加する必要があります。

今後の展望とAI活用の方向性

Claude 4.5 Haikuが体現するトレンド、すなわち専門化したAIエージェントを協調させるシステムへの移行は、今後さらに加速すると考えられます。

従来のAI活用は、単一の強力なモデルに多くのタスクを任せるアプローチが主流でした。しかし、これからのエンタープライズAIは、それぞれが特化した役割を持つ複数のモデルを組み合わせることで「構成(Compose)」される方向に進んでいくでしょう。

この変化は、単なる技術的なトレンドではありません。巨大モデルのトレーニングは収穫逓減と指数関数的なコスト増に直面している一方で、多くの複雑な問題は独立したサブ問題に分解可能です。水平スケーリングのアプローチは、「ワーカー」エージェントを追加することで問題解決能力をほぼ線形に、かつ低い限界費用で向上させることを可能にします。

このコンポーザブル(構成可能)でエージェント型のAIという新たな時代において、Claude 4.5 Haikuは基礎的な構成要素として不可欠な役割を担うことになるでしょう。

実装における注意点

実際に導入を進める上で、いくつか留意すべき点があります。

まず、モデルの「精度」と「簡潔性」は、直接的でありながら見過ごされがちな経済的利点です。不要なトークンを生成しないモデルは、複数ターンの対話において総コストを抑制します。この特性を活かすため、プロンプト設計においては具体的で明確な指示を心がけるべきです。

次に、エージェント型システムを構築する際は、適切なエラーハンドリングとフォールバック機構を実装することが重要です。複数のサブエージェントが並列で動作する環境では、一部のエージェントが失敗しても全体のワークフローが継続できる設計が求められます。

さらに、コンテキストウィンドウの管理も重要な考慮事項です。Haiku 4.5はコンテキスト認識トレーニングを受けていますが、開発者側でも適切なコンテキスト管理を行うことで、より効率的で信頼性の高いシステムを構築できます。

結びに

Claude 4.5 Haikuは、AIモデルの進化における重要な転換点を示しています。それは単に「速くて安いモデルが登場した」という話ではなく、AI活用のパラダイムそのものが変わりつつあることを象徴する存在です。

これまでAI導入を検討する際、多くの企業は「どのモデルを選ぶか」という問いに焦点を当ててきました。しかし、これからは「どのようにモデルを組み合わせるか」という問いに答える必要があります。

Haiku 4.5が提示する水平スケーリングのアプローチは、コスト面でも技術的にも持続可能な方向性を示しています。高性能なプランナーと、高速で経済的なワーカーを組み合わせることで、複雑な問題をより効率的に解決できるようになります。

企業がAI戦略を再考する上で、この変化を理解し、適切に対応することが競争優位性を確保する鍵となるでしょう。Haiku 4.5は、その新しい時代への扉を開く存在として、今後のAI活用において中心的な役割を果たしていくことが期待されます。