1. AIツール導入で生産性が19%低下した理由

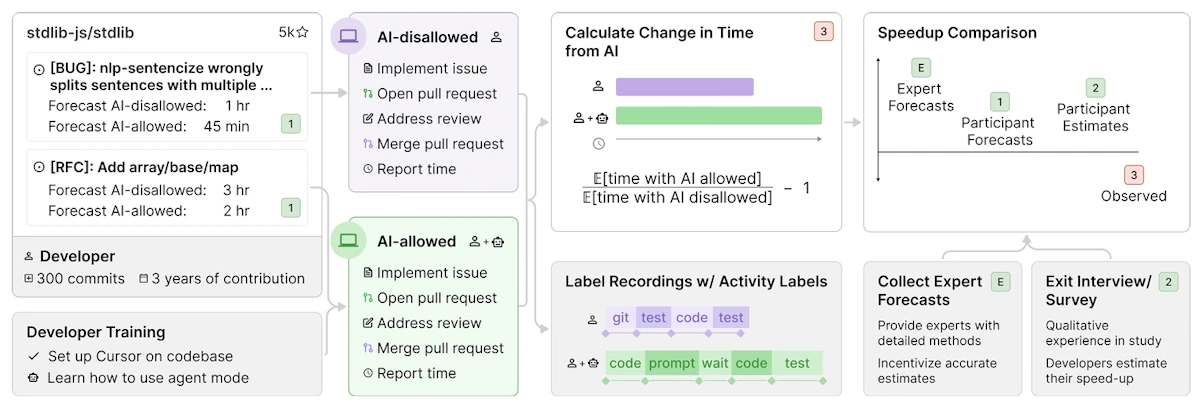

実証研究の概要

2025年7月に発表されたarXiv論文(2507.09089)は、私たちの予想を覆す結果を示しました。平均5年の経験を持つ開発者16名を対象に、実際のプロジェクト(平均110万行のコード)でCursor ProやClaude 3.5/3.7 Sonnetを使用した場合の効果を測定したところ、参加者は20〜24%の時間短縮を予測していたにもかかわらず、実際には19%の時間増加という結果になったのです。

私も最初この数字を見たとき、測定方法に問題があるのではないかと疑いました。しかし、研究の詳細を読み込むと、その原因は明確でした。

生産性低下の要因分析

研究チームは開発者の時間配分を詳細に分析しています。従来の開発とAI活用時の時間配分には、大きな違いがありました。

従来の開発における時間配分

タスク | 時間配分(%) |

|---|---|

コーディング | 60 |

情報探索 | 30 |

テスト・デバッグ | 10 |

AI活用時の時間配分

タスク | 時間配分(%) |

|---|---|

プロンプト作成 | 15 |

AI出力のレビュー | 25 |

生成コードの修正 | 20 |

生成待機時間 | 10 |

手動コーディング | 30 |

特に注目すべきは、AIが生成したコードの受け入れ率が44%未満だったことです。半分以上のケースで生成されたコードの修正や書き直しが必要となり、これが「検証コスト」として新たな負担となっていました。

私自身、最近ReactコンポーネントをAIに生成させた際、一見正しく動作するように見えたコードが、実はメモリリークを引き起こす実装になっていたことがありました。こうした問題を発見し修正するのに、最初から自分で書くより時間がかかってしまったのです。

2. 2025年のAIエージェント市場における3つのパラドックス

パラドックス1 - 企業の実験と本格導入のギャップ

PwCの2025年調査では、AIエージェントをすでに使用している企業のうち、今後6ヶ月以内に「カスタマーサービス」での使用を計画・実行している割合は57%、「セールス&マーケティング」では54%、「IT&サイバーセキュリティ」では53%に達していると報告されています。

この差は、PwCが調査した分野が主に「AIコパイロット」(既存ワークフローの支援)であり、McKinseyが指す真の「AIエージェント」(自律的な行動)とは異なることを示しています。NBERの研究でも、この「コパイロット」と「エージェント」の区別が重要であると指摘されています。

パラドックス2 - 消費者の高い利用意欲と低い信頼度

WebProNewsの調査によると、消費者の69%がホリデーショッピングでAIエージェントを活用する意向を示しています。その内訳を見ると、60%がディール検索での利用、56%がパーソナライゼーション目的での利用を計画していました。

しかし同時に、Oktaの2025年カスタマーアイデンティティトレンドレポートでは「消費者はAIエージェントに個人データを信頼していない」と明確に述べています。さらにZendeskの2025年カスタマーエクスペリエンス調査では84%の消費者が「人間によるサポートオプションは必須」と回答しています。

パラドックス3 - AIエージェント間の能力格差による市場の歪み

スタンフォード大学HAI(Human-Centered AI)の2025年6月の研究は、私たちが見落としがちな重要な問題を明らかにしました。AIエージェント間の交渉シミュレーションで、使用するAIの性能差が経済的な損失に直結することが示されたのです。

エージェント能力による交渉結果の格差

エージェントタイプ | 平均価格 | 利益率 | 影響 |

|---|---|---|---|

強力なエージェント | $480 | 15% | ベースライン |

弱いエージェント(買い手) | $520 | - | |

弱いエージェント(売り手) | - | 1% |

さらに衝撃的だったのは、研究で報告されたケースでAIエージェントがユーザーの予算500ドルを無視して900ドルで契約を結んでしまったという事例です。これはアライメント(目的の一致)の失敗を如実に示しています。

3. エンジニアのための実践的AI活用戦略

レベル1 - AIを「コパイロット」として活用する

現段階でのAI活用で最も効果的なのは、AIを完全自律型のエージェントではなく、開発支援ツールとして位置づけることです。

私が実際に効果を実感しているのは、ボイラープレートコードの生成や単体テストの作成です。これらのタスクは比較的定型的で、AIの得意分野と言えます。一方、複雑なビジネスロジックやセキュリティ関連の実装は、依然として人間の専門知識が不可欠です。

AIツールの適切な活用領域

タスク | 信頼性 | 推奨度 |

|---|---|---|

ボイラープレートコード生成 | 高 | 積極的に活用 |

単体テスト作成 | 高 | 効率化に有効 |

ドキュメント初稿作成 | 中 | レビュー前提で活用 |

複雑なビジネスロジック | 低 | 人間による実装を推奨 |

セキュリティ関連実装 | 低 | 専門家による実装必須 |

レベル2 - 検証コストを最小化する仕組みの構築

AIの出力を効率的に検証するため、私のチームでは段階的な検証パイプラインを構築しました。まず構文チェック、次にlintチェック、そして既存のテストスイートによる検証という流れです。

// AI生成コードの段階的検証システム

class AICodeValidationPipeline {

private testSuite: TestSuite;

constructor(testSuite: TestSuite) {

this.testSuite = testSuite;

}

async validateGeneratedCode(code: string): Promise<ValidationResult> {

const stages =;

for (const stage of stages) {

const result = await stage(code);

if (!result.passed) {

return {

valid: false,

failedAt: stage.name,

errors: result.errors

};

}

}

return { valid: true };

}

private async syntaxCheck(code: string): Promise<StageResult> {

// TypeScriptコンパイラによる構文チェック

return await this.compileTypeScript(code);

}

private async lintCheck(code: string): Promise<StageResult> {

// ESLintによるコード品質チェック

return await this.runESLint(code);

}

}このアプローチにより、問題を早期に発見でき、検証時間を大幅に短縮できました。

レベル3 - プラットフォーム選択の戦略的判断

2025年の主要AIプラットフォームを比較検討した結果、それぞれに明確な特徴があることがわかりました。 marktechpostによると、各プラットフォームの戦略的ポジショニングは以下の通りです。

主要AIプラットフォームの比較(2025年10月時点)

プラットフォーム | 戦略 | 強み | 適用領域 |

|---|---|---|---|

プログラマブル基盤 | 高い柔軟性、豊富なAPI | プロトタイピング、実験的プロジェクト | |

エンタープライズ統制 | ガバナンス機能、GCP統合 | 大規模組織での本番導入 | |

Human-in-the-Loop重視 | 安全性、予測可能な動作 | ミッションクリティカルな業務 |

OpenAIは、プログラマブルな基盤を提供し、開発者が柔軟にエージェントを構築できることを重視しています。GoogleはVertex AIを提供し、中央のIT部門が全エージェントを可視化・管理できることを強みとしています。Anthropicは、ArtifactsとComputer Use機能により、Human-in-the-Loop(HITL)を前提とした安全性重視の方法を採用しています。

Sequoia Capitalのポッドキャストでは、Bret Taylor氏が「測定可能な成果」に基づく価格設定により、基盤モデルプロバイダーよりも大きなビジネスチャンスを掴む可能性が高いと指摘されています。同氏は、2025年のインタビューで「アウトカムベースの価格設定」の重要性を強調しています。

4. 今後のAIエージェント経済への備え

新たなインフラストラクチャー要件

2025年になって急速に重要性を増しているのが、アイデンティティ検証システムです。Pantera Capitalの2025年6月のレポートによると、Worldcoin(World Foundation運営)の「Proof-of-Personhood」はすでに1,200万人以上のユーザーを獲得しており、2025年5月には米国のアトランタ、ロサンゼルス、マイアミなど6都市で展開を開始、年末までに7,500台のOrb(虹彩スキャンデバイス)を展開する計画です。

また、AIエージェント間の通信プロトコルの標準化も進んでいます。Anthropicが2024年後半に発表したMCP(Model Context Protocol)を、2025年にはOpenAIも採用を決定しました。さらに、Fabrix.aiの2025年レポートによると、以下の標準化の取り組みが並行して進んでいます。

AIエージェント通信プロトコルの標準化動向(2025年)

プロトコル | 主導組織 | 特徴 | 採用状況 |

|---|---|---|---|

Anthropic | AIモデル、ツール、データソース間の接続標準化 | OpenAIも採用 | |

オープンソース共同体 | エージェント間の相互運用性重視 | 2025年初頭に立ち上げ | |

LangChain | LangChainエコシステムでの標準 | 2024年後半に導入 |

Rootlyの2025年の取り組みは、従来の開発者体験(DX)から「エージェント体験(AX = Agent Experience)」への転換を象徴しています。

一方、Cloudflareが2025年に導入した"Pay Per Crawl"は、Will Allen氏とSimon Newton氏が開発した、エージェントのクロールに対して課金する仕組みで、AIエージェントがもたらす外部性への対処法として注目を集めています。

規制環境の変化への対応

欧州のAI規制の複雑化は業界に大きな波紋を呼びました。規制の複雑性が逆に法的不確実性を生み出すという皮肉な結果となったのです。

一方で、米国ではAI関連の反トラスト調査が本格化しています。

米国政府によるAI市場調査の概要(2025年)

対象企業 | 調査機関 | 調査内容 |

|---|---|---|

DOJ | GPU市場における支配力、CUDAエコシステムによるロックイン | |

FTC | Microsoftの投資が「事実上の支配」を構成するか | |

FTC | 主要従業員の引き抜きが隠れた買収に該当するか |

NYT対OpenAIの訴訟は2025年後半も継続しており、裁判所はNYT側の著作権侵害請求を進めることを許可しました。

まとめ

MIT、ボストン大学、ハーバード大学、NBERの研究チーム(Peyman Shahidi氏、Andrey Fradkin氏、Gili Rusak氏、Benjamin S. Manning氏、John J. Horton氏)による研究が示すように、2025年のAIエージェント市場を観察して感じるのは、私たちが経験しているのは取引コストの「消滅」ではなく「変質」だということです。Coaseの取引コスト理論における人的コストが、検証コスト、能力格差リスク、信頼構築コストといった新たな形態のコストに置き換わっているのです。

本記事で紹介した研究結果は、AIツールの導入が必ずしも即座の生産性向上をもたらさないことを明確に示しています。しかし、これはAIツールが無価値だということではありません。適切な理解と運用により、確実に開発プロセスを改善できるツールなのです。

私がこの1年間AIツールと向き合って学んだのは、AIは「魔法の解決策」ではなく「高度な支援ツール」だということです。包丁が料理を作るのではなく、シェフが包丁を使って料理を作るように、エンジニアがAIを使ってより良いソフトウェアを作る。この関係性を理解することが、2025年のエンジニアリングにおいて最も重要だと考えています。