中間とりまとめの背景と策定プロセス

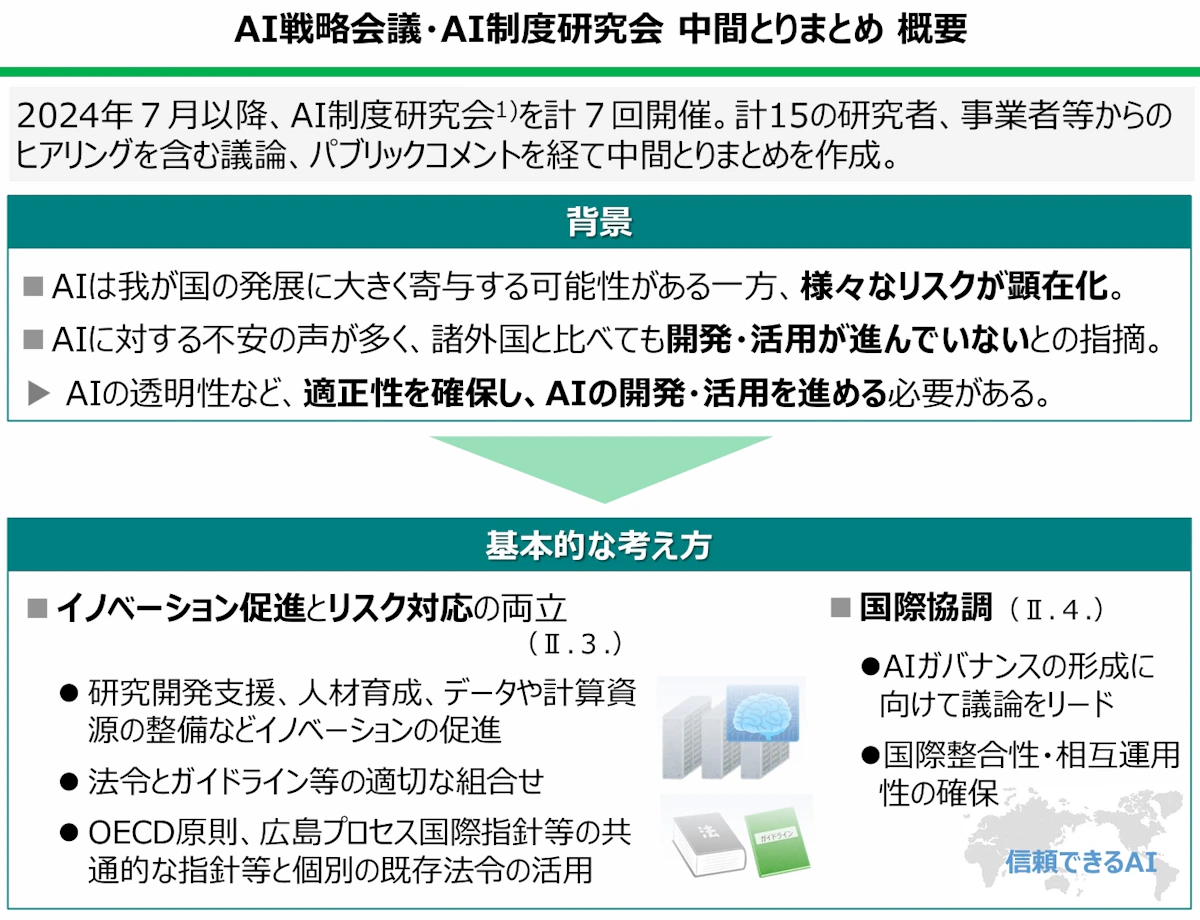

日本政府は2024年7月にAI制度研究会を設置し、計7回の会議と15の関係者からのヒアリングを経て、2025年2月に中間とりまとめを公表しました。この文書が策定された背景には、生成AIの急速な発展と、それに伴うリスクの顕在化という状況があります。

国内では、AIを利用した偽サイトや合成音声による詐欺事件、ディープフェイクによる名誉毀損事件、生成AIを用いたコンピュータウイルス作成事件など、様々な犯罪が実際に発生しています。一方で、日本におけるAI利用率は諸外国と比較して著しく低い状況にあります。総務省の調査によれば、生成AIを利用している個人は9.1%にとどまり、中国の56.3%、米国の46.3%と大きな差があります。企業でも同様の傾向が見られます。

こうした状況を受けて、AIに対する不安の声が多く聞かれる一方で、開発・活用が進んでいないという課題に対応するため、本制度研究会が立ち上げられました。研究会では、研究者、事業者、自治体を含む様々な関係者からヒアリングを行い、パブリックコメントを経て中間とりまとめを作成しています。

制度設計の基本方針と4つの基本原則

中間とりまとめの最大の特徴は、「イノベーション促進とリスク対応の両立」という明確な方針を打ち出している点です。これは単なる規制強化でもなく、また野放図な自由化でもありません。研究開発への支援や人材育成といったイノベーション促進策と、法令とソフトローを適切に組み合わせたリスク管理を同時に推進するという、バランスの取れたアプローチを示しています。

検討にあたっては、広島AIプロセスの精神に基づき、以下の4つを基本原則として議論が行われました。

まず第一に、リスク対応とイノベーション促進の両立です。過度な規制によってAI開発・利用が萎縮することを避けつつ、必要なリスク管理を行うというバランスが重視されています。

第二に、技術・ビジネスの変化の速さに対応できる柔軟な制度の設計です。AI技術は日々進化しており、硬直的な規制では対応できません。法令とガイドラインを適切に組み合わせることで、迅速な対応を可能にする方針が示されています。

第三に、国際的な相互運用性の確保です。日本企業が海外市場に進出しやすく、また海外事業者との公平な競争環境を整備するため、国際整合性が重視されています。

第四に、政府によるAIの適正な調達と利用です。政府が率先してAIを適切に活用することで、国内のAI市場の発展を促進する方針が打ち出されています。

AIライフサイクルにおける3つの主体と役割

中間とりまとめでは、AIのライフサイクルにおける関係主体を「AI開発者」「AI提供者」「AI利用者」の3つに分類しています。この分類は、責任の所在を明確にし、各主体が果たすべき役割を整理する上で重要な枠組みとなります。

表 AIライフサイクルにおける各主体の役割

主体 | 主な役割 | 具体的な活動内容 |

|---|---|---|

AI開発者 | データ収集・モデル開発 | データ収集、モデル学習、システム基盤構築、入出力機能開発 |

AI提供者 | AIシステムの実装・提供 | 既存/新規システムへのAI組込み、サービス提供可能な状態での提供 |

AI利用者 | AIサービスの活用 | 提供されたAIシステムのサービス組込み、AIサービスの利用 |

この整理が示唆するのは、AIシステムが開発から利用に至るまでの過程で、複数の主体が関与し、それぞれが異なる責任を負うという構造です。例えば、開発時点でのリスク評価の結果が、提供者を経て利用者に適切に共有されなければ、利用段階でリスクが顕在化する可能性があります。

実際のビジネスにおいては、一つの企業が複数の役割を兼ねることもあります。大手IT企業が自社でAIモデルを開発し、それをクラウドサービスとして提供し、さらに自社の業務でも利用するといったケースです。このような場合、各段階での責任と必要な対応を明確に区別して管理する必要があります。

重点施策1 司令塔機能の強化と戦略の策定

中間とりまとめが示す具体的な制度・施策の第一は、政府の司令塔機能の強化と戦略の策定です。AIは利用分野や用途の広がり、汎用型AIの登場等により、研究開発から活用に至るまでの期間が短い場合も存在し、その間の各段階における取組がほぼ同時並行的に行われ得るものです。

このため、研究開発から活用に至るまでに介在する多様な主体や過程における取組が互いに密接に関連し、一体的・横断的に行われる必要があります。研究開発から経済社会における活用までの一体的な施策を推進する政府の司令塔機能を強化すべきとされています。

AIは、政府・自治体での活用を含め、国民生活の向上のための様々な場面での利用だけでなく、犯罪への悪用の懸念もあるほか、デュアルユース技術の側面も持つため、司令塔機能の強化に際しては、広く関係府省庁が参加する政策推進体制を整備する必要があります。

また、総合的な施策の推進にあたっては、司令塔が戦略あるいは基本計画を策定する必要があります。AIについては、安全・安心の確保がAIの活用の促進、イノベーションの促進、安全保障リスクへの対応、犯罪防止等にとって重要であることから、AIの安全・安心な研究開発、活用の促進等に資する戦略とすべきとされています。

これらについては、AIの司令塔機能の強化や、司令塔による関係行政機関に対し協力を求めることができる等の権限を明確化するため、法定化すべきであるとされています。この方針は、AI制度の実効性を確保するための重要な基盤となります。

重点施策2 透明性と適正性の確保

第二の重点施策は、AIライフサイクル全体を通じた透明性と適正性の確保です。AIの開発から利用に至るまでには複雑なプロセスがあり、その過程でAIシステムの能力は変化し、リスク評価の結果も変化している可能性があります。

例えば、モデル構築のために膨大な量の学習データを使用し、その後チューニング等を経て開発者から提供者にAIシステムが渡り、さらに提供者が追加学習をした上で利用者にAIサービスを提供する場合を考えてみましょう。開発者が開発したAIシステムと提供者が利用者にAIサービスを提供する際のAIシステムとではその能力は変化しています。

利用者の側では必ずしも開発時点でのリスクへの対応について把握することができない中で、リスクに対応するにあたっては、このようなリスクに係る必要な情報を関係者に適切に共有しなければ、誤った認識でAIシステムを提供者が利用者に提供し、あるいは利用者が不適正にAIサービスを利用し、リスクが顕在化する可能性があります。

このため、AIの安全・安心な研究開発や活用には、開発者と提供者の間、提供者と利用者の間において必要な情報を共有する透明性を確保すべきとされています。ただし、かかる透明性の確保のための措置が事業者の事業運営に過度な負担や広範すぎる情報開示とならないよう、また研究開発段階においては未だ実際の利用に供されていないこと、及び研究開発に関する情報は企業の機密にかかわることが多いことから、情報の共有は真に必要な範囲に留めることが重要であるとされています。

適正性については、広島AIプロセスで合意された国際指針の趣旨を踏まえた指針を政府が整備などを行い、事業者に対し各種規範等に対する自主的な対応を促していくことが適当とされています。当該指針については、例えば以下のような内容について検討することが重要とされています。

引用:AI戦略会議・AI制度研究会 中間とりまとめ 不適切な出力を減らすための工夫をAI開発者等が講じること、AIの概要やリスク等に関する情報をAI開発者等が開示・共有すること、訓練用データセットの適切な透明性も支援されるべきであること等について検討することが重要である

透明性と適正性の確保については、調査等により政府が事業者の状況等を把握し、その結果を踏まえて既存の法令等に基づく対応を含む必要なサポートを講じるべきとされています。この政府による事業者の状況等の把握や必要なサポートについては、事業者の協力なしでは成り立たないため、国内外の事業者による情報提供等の協力を求められるように、法制度による対応が適当であるとされています。

重点施策3 安全性評価と認証の戦略的促進

第三の重点施策は、国内外の組織が実践する安全性評価と認証に関する戦略的な促進です。AIの安全・安心な活用の促進にあたっては、安全性評価や認証制度の実施も一つの有効な手段とされています。

安全性の評価や認証制度は、AIシステムに関する評価・認証と、AIを利用する組織のガバナンス等に関する評価・認証とに大別されます。AIシステムの安全性の評価について、リスクを理解するAIの開発者、提供者や利用者は、組織内外の専門家チームや評価用のツールなどを使って、基本的には自らリスク評価を行い対処していくべきとされています。

将来的に有用な第三者認証が確立されるならば、AI開発者や提供者がかかる第三者認証を取得することにより、一般国民を含め多くの利用者やこれまでAIサービスを扱っていなかった提供者がAIの安全性を評価することも考えられます。提供者や利用者は、第三者認証の有無によって、安全性の高いAI事業者やそのAIシステムを認識し、選択することが可能となります。

一方、AIを利用する組織のガバナンスに関しては、利用者が自ら体制を構築して評価する場合と、第三者認証制度を活用する場合が考えられます。第三者認証制度は、AIの安全・安心な活用を促進し、日本のAI産業の活性化に寄与する方策の一つとなると考えられます。

なお、AIシステム、AIを利用する組織のガバナンスの認証については、ISOなどで検討がなされている状況です。安全性については電気用品安全法、医薬品医療機器等法といった個別法により規律が既に導入されているほか、「AI事業者ガイドライン」による対応もなされています。また、各国のAISIのコミュニティ、ISO、IECなどにおいても議論が行われている状況です。

国際的な基準や規格を作る活動は、将来の世界的な市場においてAIシステムの相互運用性を確保するために重要であり、積極的かつ戦略的に対応する必要があります。また、国内における制度整備は、国際的な規範を踏まえ、かつ制度の実効性も考慮し対応すべきとされています。

AIの評価や認証を実施する場合には、利用者や利用目的に従ってレベルを設けることや、一定の安全性を確認するための利用者の負担が軽減する仕組みや評価・認証を実施する機関を認定する仕組みを構築できれば、より効果的で持続可能な制度となると考えられます。ただし、この仕組みを構築する際は、AISIやISOなどの活動を前提にしつつ、どのような主体を巻き込み、どのような基準で評価を行っていくのか、詳細な検討が必要とされています。

重点施策4 重大インシデント調査と情報発信

第四の重点施策は、重大インシデント等に関する政府による調査と情報発信です。AIは近年急速な発展を遂げており、様々なリスクが増大しています。このような中、AIのリスクに対処し、政府として適切な施策を実施するためには、技術及び事業活動の双方の側面から時々刻々と変化するAIの開発、提供、利用等に関する実態をまず政府において情報収集・把握することが必要です。

事業者においてAIが効果的かつ適正に利用されるとともに、広く国民がAIの研究開発や活用の促進に対する理解と関心を深められるよう、企業秘密等に配慮しつつも説明責任を果たせるように、必要な範囲で国民に情報提供することが適当とされています。

中でも、多くの国民が日々利用するようなAIモデルについては、政府がサプライチェーン・リスク対策を含むAIの安全性や透明性等に関する情報収集を行い、国民に対して広く情報提供されることで、利用者は安全性の高いAI事業者やそのAIシステムを認識・選択しやすくなります。また、基盤サービス等におけるAI導入の実態等に関しては、政府による情報収集が重要とされています。

また、AIの利用に起因する重大な事故が実際に生じてしまった場合、政府としては、その拡大又は再発の防止を図るとともに、AIを開発・提供する事業者による再発防止策等について注意喚起を行っていく必要があります。

すなわち、国内で利用されるAIについて、国民の権利利益を侵害するなどの重大な問題が生じた場合、あるいは生じる可能性が高いことが検知された場合において、その原因等に関する事実究明を行い、必要に応じて関係者に対する指導・助言を行い、得られた情報の国民に対する周知を図るべきとされています。なお、事故が生じているといえるか否かについては、上記の情報収集・把握を通じて政府に蓄積された事例や知見をもとに判断していくことが重要とされています。

この調査や情報発信は事業者の協力なしでは成り立たないため、国内外の事業者による情報提供等の協力を求められるように、法制度による対応が適当とされています。この方針は、AI利用に伴うリスクの早期発見と対応、そして国民への適切な情報提供を可能にする重要な仕組みとなります。

重点施策5 政府調達と政府によるAI利用

第五の重点施策は、適正なAI政府調達・利用等です。日本における個人及び企業によるAI利用率は、他国と比較すると著しく低迷している状況にあり、このような状況を放置すれば、日本の国際競争力が損なわれるおそれがあります。

AIは国民生活や経済活動の発展の基盤として、その利用の重要性が増していくことが見込まれる中、このような状況を放置すれば、日本の国際競争力が損なわれるおそれがあるため、まずは政府が率先してAIを利用し、国民による活用を促進することが考えられます。

政府が情報システム等を調達する際は、既存の申合せに基づき、サプライチェーン・リスクに対応することが必要であると判断されるものについては、内閣サイバーセキュリティセンター及びデジタル庁と協議の上、必要な措置を講じることとしており、AIについても同申合せの対象となります。

一方で、現時点において、AI調達に特化したガイドライン等はないところ、AIには様々なリスクが存在することから、これに対応するため、政府がAIを調達する際に参考となるAIに特化した政府調達ガイドライン等の整備や既存のAIに関するガイドライン等の深掘りなどを行うことが重要とされています。

また、このような政府調達に関するガイドライン等を整備することで、AIを利用する事業者が何らかのAIシステム・サービスを利用する際の参考にもなり、安全性の高いAIの普及促進に貢献できると考えられます。なお、ガイドライン等の整備にあたっては、AIのリスクの軽減や品質の確保を図ると同時に、透明性の確保を求める場合は利用シーンに応じた企業の負担を考慮し、多くの事業者による容易かつ迅速な参加が可能となるように配慮すべきとされています。

政府がAIを利用することにより、行政サービスや業務等の質・効率を向上させることができるほか、政府がユースケースやその有用性を示し、具体事例、留意点等を周知することにより、AIの活用を促進し、国内のAI市場の発展等にも貢献できるため、政府が率先してAIを利用していくことは重要とされています。ただし、国民の権利利益に重大な影響を及ぼしかねないものについては、AIの出力結果を自動的に採用することのリスクを踏まえ、慎重に取り組むべきであるとも指摘されています。

地方自治体についても、行政サービスの大きな部分を占めており、国民生活への影響も大きいため、AIの利用を推進し、行政サービスや業務等の質・効率を向上させていくことが重要とされています。また、地方自治体におけるAIの利用の推進にあたっては、各自治体の先進的な取組を含む利用事例を参考にするほか、各自治体の地域課題に応じたAIの利用も重要とされています。

法令とソフトローの組み合わせによる実効性確保

中間とりまとめが提示する制度設計の核心は、法令による対応とガイドライン等のソフトローによる対応を適切に組み合わせるという考え方です。この方針は、AI技術の急速な発展と多様な利用形態に対応するための現実的なアプローチといえます。

法令による対応には、公的機関による強制力の発動が可能であり、規律の実効性が得られやすいという利点があります。一方で、規制を行った分野の発展を阻害する可能性や、明確な規制を定めるのに時間を要するという欠点もあります。対照的に、ソフトローによる対応は、国際情勢や最新技術の動向に合わせた迅速かつ柔軟な対応が可能であり、イノベーションに与える負の影響が少ないという利点がありますが、事業者等の自主的な対応に頼らざるを得ない側面があります。

中間とりまとめは、上記の観点から、イノベーション促進とリスクへの対応の両立を確保するため、法令とガイドライン等のソフトローを適切に組み合わせ、基本的には事業者の自主性を尊重し、法令による規制は事業者の自主的な努力による対応が期待できないものに限定して対応していくべきであるとしています。

また、既存の個別の法令の存在する領域においては、AIが各領域で様々な用途で利用され始めており、権利利益の保護の必要性が生じる場面もAIの用途に応じて異なることから、まずは当該法令の枠組みを活用しつつ対応すべきとされています。その上で、そのような領域以外に関して新たな制度を創設する場合も含め、仮に法律上の規制による対応を行う場合には、事業者の活動にもたらす影響の大きさを考慮しつつ、AIのもたらすリスクを踏まえた上で、真に守る必要のある権利利益を保護するために必要な適用内容とすべきとされています。

その際、政府と事業者との役割分担を意識した上で、何が規制の対象となり、事業者の活動はどこまで許容されているのかといった線引きを明確化することが重要です。また、「規制はその目的を達成するために、特定の種類の技術の使用を強制したり、優遇したりすべきではない」という規制の技術中立性の原則も踏まえた検討も重要とされています。

なお、AIの安全性に関する正当な研究を行うために不適切なAIを試作するケース等における規制の適用については、その要否も含め検討を行う必要があるとされています。また、広く事業者一般を対象とする制度を検討する際には、スタートアップ企業も含め、どのような規模の事業者であっても対応可能なものとなるよう、制度への対応に伴う事業者の負担を考慮する必要があるとされています。

AIがもたらすリスクと既存法令による対応

中間とりまとめでは、AIのもたらし得るリスクの例と関係する主要法令が整理されています。これらのリスクに対しては既存の法令で一定の対応がなされていることを前提に、更なる制度の検討を行う必要があるとされています。

表 AIのもたらし得る主なリスクと関連法令

リスク分類 | 具体例 | 関連する主要法令等 |

|---|---|---|

秘密情報の漏洩 | 外部AIサービスへの企業秘密入力 | 不正競争防止法、民法 |

著作権侵害 | 学習・生成での他者著作物利用 | 著作権法 |

産業財産権侵害 | 登録商標の学習・生成 | 意匠法、商標法 |

プライバシー侵害 | 無断での個人情報のAI学習利用 | 個人情報保護法 |

生命・身体の安全 | AI搭載製品の誤作動 | 製造物責任法、各業法 |

ディープフェイク | 合成画像・音声の悪用 | 刑法、児童ポルノ禁止法 |

バイアスの助長 | 不適切なAIによる採用判断 | 労働関係法令、民法 |

偽・誤情報 | AIで作成した虚偽情報の拡散 | 公職選挙法、民法、刑法 |

サイバー攻撃 | 生成AIでウイルス作成 | 刑法、不正アクセス禁止法 |

国内においても、性的な動画コンテンツの出演者の顔を芸能人の顔にすり替えインターネット上に公開した事件、生成AIを用いてコンピュータウイルスを作成した事件、生成AIを用いて女性のキャラクターを作って現金をだまし取った事件などが実際に発生しています。

リスクに対しては既存の法令で一定の対応がなされていることを前提に、更なる制度の検討を行う必要があります。例えば、2023年6月には個人情報保護委員会が個人情報取扱事業者や行政機関等に対し、生成AIサービスの利用に際しての個人情報の取扱いに関する注意点を示しつつ、個人情報保護法に従って個人情報を適正に取り扱うよう注意喚起を行っています。

また、2024年3月には文化庁の文化審議会著作権分科会法制度小委員会が、生成AIが膨大なデータを学習し、コンテンツを生成する際に著作権の侵害が生じるのではないかという懸念に対し、AIと現行の著作権法の関係についての解釈に当たっての一定の考え方を示しています。

さらに、2024年4月には総務省及び経済産業省が「AI事業者ガイドライン(第1.0版)」を公表し、法の支配、人権、民主主義、多様性及び公平公正な社会を尊重するようAIシステム・サービスを開発・提供・利用すべきである旨等を示しています(2024年11月には時点更新等を施した第1.01版を公表)。

基盤サービス等と安全保障への個別対応

医療機器、自動運転車、基盤サービス等、特に国民生活や社会活動に与える影響が大きい生命・身体の安全やシステミック・リスクに関わるものについては、特に注力して対応する必要があると指摘されています。

システミック・リスクとは、特定のシステムの不全が関連するシステムにも波及し、広範囲に深刻な影響を及ぼすリスクを指します。将来的には、複数のAIシステムが連動する大規模なAIシステム群が社会システムを支える状況となる可能性があり、その際、当該AIシステム群が予期せぬ挙動をした場合、社会全体に大きな混乱をもたらす可能性があります。

現時点においては、業界毎に各業所管省庁が既存の業法に基づき対応し、また追加的な対応の必要性の有無を判断するため、AI技術の発展、利用状況について随時業界と対話している状況です。引き続き各業所管省庁が既存の法令あるいはガイドライン等の体系の下で対応すべきとされていますが、今後新たなリスクが顕在化し、既存の枠組で対応できない場合には、政府は関連する枠組の解釈を明確化した上で、制度の見直しあるいは新たな制度の整備等を含めて検討すべきとされています。

また、CBRNの開発やサイバー攻撃等へのAIの利用といった国の安全保障に関わるリスクについては、日本の安全保障を確保するという観点から、関係省庁において必要な対応をさらに検討していく必要があるとされています。AIにはデュアルユース技術の側面もあり、CBRN(化学・生物・放射性物質・核を用いた兵器等)の開発やサイバー攻撃等にAIが使用される安全保障上のリスクも指摘されています。

国際協調と相互運用性の重要性

中間とりまとめが重視するもう一つの重要な視点が、国際協調と相互運用性の確保です。日本の国民はインターネットを通じて様々な国の事業者等のAIサービスを利用することができ、また日本のAIサービスは世界各国の人々が利用することができます。

このような状況において、満たすべき安全性等に係る国際的な規範と日本において適用される規範の相互運用性が確保されている場合、日本の事業者が円滑に海外市場に進出できるほか、日本の国民が全世界のAIサービスにアクセスすることが可能となるため、国際整合性・相互運用性の確保は重要とされています。

日本が議長国を務めた2023年のG7では、生成AIに関する国際的なルールの検討のため「広島AIプロセス」を立ち上げ、安全、安心で信頼できるAIの実現に向け、「全てのAI関係者向けの広島プロセス国際指針」及び「高度なAIシステムを開発する組織向けの広島プロセス国際行動規範」を策定しました。

その後、日本は、G7を超えたアウトリーチとして、広島AIプロセス・フレンズグループを立ち上げ、広島AIプロセスの精神に賛同する国々の拡大を図っています。2024年5月時点で49の国・地域が賛同しています。また、2024年には、G7議長国のイタリアが広島AIプロセスを引き継ぎ、国際行動規範の履行状況の報告枠組みについて議論が行われています。

このほか国連、欧州評議会、OECDなどの多国間の枠組みにおいても、AIガバナンスに関する議論が活発に行われています。国連においては、2024年9月に未来サミットの成果文書の附属文書として「グローバル・デジタル・コンパクト」が採択され、AIのリスクや機会の評価を通じた科学的理解を促進するためのAIに関する国際科学パネルの設置や、各国政府及び関連するステークホルダーが参加するAIガバナンスに関するグローバル対話の開始等が盛り込まれました。

欧州評議会においては「人工知能と人権、民主主義及び法の支配に関する欧州評議会枠組条約」が成立し、現在、EUに加え、米国、英国等の10か国が署名している状況です。OECDにおいては、2019年に公表した、包摂的な成長、持続可能な開発及び幸福、人間中心の価値観及び公平性等からなるAI原則を、急速な発展を遂げる生成AIによる偽・誤情報のリスク等に対応させるため、2024年5月に改定しています。

AIに係る制度・施策の実施にあたっては、これら国際的な枠組等において合意あるいは認められた取決や考え方を踏まえ対応すべきとされています。広島AIプロセスの重要性はもちろんのこと、ISO、IEC等における国際規格を定める標準化活動は、将来の世界的な市場や事業活動の発展にとって重要であり、幅広い関係者による議論を行い長期的な視野を持ち、積極的に進めていく必要があります。

事業者への実務的示唆と今後の対応

中間とりまとめが示す方向性は、Sier企業やIT戦略に携わる事業者にとって、以下のような実務的な示唆を含んでいます。

まず、自主的なリスク管理体制の構築が求められます。法令による規制は必要最小限とし、基本的には事業者の自主性を尊重するという方針のもと、事業者は自らリスク評価を行い、適切な対応を講じる体制を整備する必要があります。これは単なる規制対応ではなく、競争優位性の源泉となり得ます。

次に、AIライフサイクルにおける各主体間の情報共有と連携が重要です。開発者、提供者、利用者それぞれが果たすべき役割を理解し、必要な情報を適切に共有する仕組みを構築することが求められます。特に、サプライチェーン全体でのリスク管理の視点が重要となります。

安全性評価や認証制度への対応も検討課題です。将来的に有用な第三者認証が確立される可能性があり、早期から準備を進めることで市場での競争優位性を確保できる可能性があります。また、認証取得に向けた体制整備は、組織のガバナンス強化にもつながります。

政府による調達ガイドラインの整備は、新たなビジネス機会となる可能性があります。政府調達に対応できる体制を整備することで、公共部門での採用が進み、さらに民間部門への展開も期待できます。

国際整合性の確保という方針は、海外展開を視野に入れる企業にとって重要です。広島AIプロセスやISO等の国際標準化活動への参画は、将来の市場形成に影響を与える重要な取り組みとなります。

また、政府が法制度化を進めるという方針は、AI制度の実効性確保を意味しています。事業者としては、今後の法制度の動向を注視し、早期から対応準備を進めることが賢明です。特に、透明性と適正性の確保、重大インシデント発生時の対応など、法制度化される可能性が高い領域については、先行して体制整備を進めることが推奨されます。

中間とりまとめが示す今後の展望

中間とりまとめは、世界で最もAIを開発・活用しやすい国を目指しつつ、人間中心の価値に基づく信頼できるAIの実現を掲げています。この方針のもと、政府に対しては、本とりまとめを踏まえ、世界で最もAIを開発・活用しやすく、かつ、人間中心の価値に基づく、他国のモデルとなるようなAIに係る法制度を含む制度整備を速やかに実施していくことが期待されています。

今回の中間とりまとめは、AIのもたらし得るリスクへの対応として、広く一般的に使われるAIを対象とする指針を政府が整備などを行い、透明性・適正性の確保が事業者主導で進むよう促しつつも、生命・身体の安全や安全保障の確保は当然の前提として、AIの開発、利用等の実態を含めた様々なリスクへの対応状況を政府が調査・把握し、重大な問題が生じた場合、あるいは生じる可能性が高い場合には、既存の法令等に基づく対応や、必要なサポートを講じるべきであるとしています。

上記の政府による指針の整備・対応やAIに関する実態の調査・把握にあたっては、事業者による自主的な対応も重要ですが、実効性を確保することが必要であるため、事業者の活動にもたらす影響等を考慮しつつ、法制度により実施すべきとされています。なお、これらの法制度による対応にあたっては、広島AIプロセス等でも確認された、法の支配、適正手続き、民主的責任行政、及び基本的人権、特にプライバシー権などの基本原理を遵守し、法制度がイノベーション促進の阻害とならないように留意する必要があります。

今後、政府による具体的な法制度の検討と整備が進められることになりますが、その過程においても事業者や有識者との対話が継続されることが期待されます。AI技術は日々進化しており、制度もそれに合わせて柔軟に対応していく必要があります。Sier企業やIT戦略に携わる事業者としては、この中間とりまとめが示す方向性を理解し、自社のAI戦略に反映させることが、今後のビジネス展開において重要となるでしょう。