調査概要

- 調査方法:インターネットリサーチ

- 調査対象:事業責任者(経営者・役員・事業部長クラス)

- 有効回答数:550名

- 調査時期:2026年1月

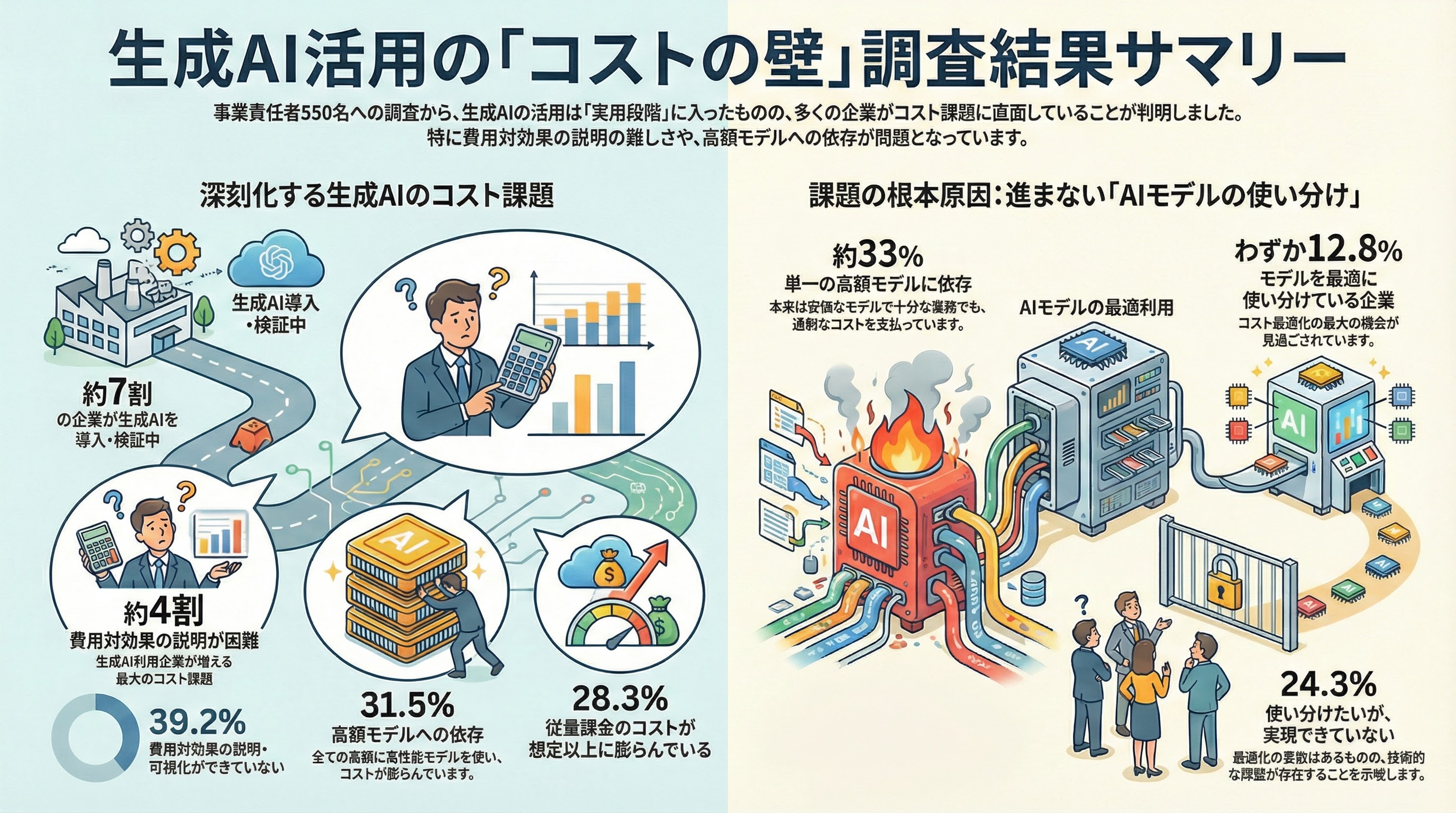

調査結果サマリー

1. 自社における生成AIの利用状況

まず、自社における生成AI(ChatGPT、Claude、Gemini等)の利用状況を調査しました。

【生成AIの利用状況】(n=550)

選択肢 | 割合 |

|---|---|

一部の部門・業務で本番運用している | 31.8% |

PoC・検証段階である | 24.6% |

着手していない/わからない | 19.7% |

検討中・情報収集中 | 12.4% |

全社的に本番運用している | 11.5% |

私たち見解/分析

- 本番運用している企業(全社+一部)は43.3%

- PoC・検証段階を含めると、約7割の企業が何らかの形で生成AIに取り組んでいる

- この結果は、生成AIが「実験的技術」から「実用段階」に移行していることを示す

2. 生成AIの利用コストに関する課題

生成AIを利用している企業が抱えるコスト面の課題を調査しました(複数回答)。

【利用コストに関する課題(複数回答)】(n=373 ※生成AI利用中の回答者のみ)

選択肢 | 割合 |

|---|---|

費用対効果の説明・可視化ができていない | 39.2% |

特に課題は感じていない | 35.4% |

高額なモデル(GPT、Claude等)に依存している | 31.5% |

従量課金のコストが想定以上に膨らんでいる | 28.3% |

利用量拡大時のランニングコストが読めない | 23.6% |

コスト最適化の方法がわからない | 19.8% |

重要なインサイト

- 約4割の企業が「費用対効果の説明・可視化ができていない」と回答

- 「高額モデルへの依存」を課題とする企業が31.5%存在

- 「コスト最適化の方法がわからない」という声も約2割

- 一方で「特に課題は感じていない」も35.4%であり、コスト意識の差が企業間で大きい

3. AIモデルの使い分け状況

業務内容に応じてAIモデルを使い分けているかを調査しました。

【AIモデルの使い分け状況】(n=373 ※生成AI利用中の企業)

選択肢 | 割合 |

|---|---|

単一のモデルで運用している | 32.6% |

使い分けたいが、実現できていない | 24.3% |

使い分けの必要性を感じていない | 15.8% |

わからない | 14.5% |

用途別に最適なモデルを使い分けている | 12.8% |

考察

- 用途別にモデルを使い分けている企業はわずか12.8%

- 約3割の企業が単一モデルに依存しており、コスト最適化の余地が大きい

- 「使い分けたいが実現できていない」企業が24.3%存在し、技術的サポートへのニーズが示唆される

AIモデルの使い分けは、コスト最適化の最も効果的なアプローチの一つです。例えば:

- 高精度が必要な業務→ Claude Opus/Sonnet、GPT等

- 定型処理・大量処理→ Claude Haiku、Amazon Nova等の安価なモデル

- 画像認識→ Amazon Rekognition(LLMより大幅に安価)

このような使い分けにより、品質を維持しながらコストを大幅に削減できます。

4. コスト削減に向けた取り組み意向

生成AIのコスト削減に向けて、どのような施策に興味があるかを調査しました(複数回答)。

【コスト削減施策への興味(複数回答)】(n=373 ※生成AI利用中の回答者のみ)

選択肢 | 割合 |

|---|---|

業務別の最適なモデル選定・配置設計 | 36.2% |

特に興味はない | 35.8% |

AIワークフローの最適化(無駄な呼び出し削減) | 28.1% |

自社データで学習したカスタムLLMの構築 | 27.8% |

専用AI(画像認識・文書解析等)との使い分け | 27.4% |

従量課金から固定型への移行 | 16.2% |

示唆

- 「業務別の最適なモデル選定」への興味が最も高く36.2%

- 「カスタムLLM構築」「ワークフロー最適化」「専用AIとの使い分け」への興味は約27〜28%で拮抗

- 約65%の企業が何らかのコスト削減施策に興味を示している

5. 外部パートナーとの協働意向

生成AIのコスト最適化における外部パートナーとの協働状況を調査しました。

【外部パートナーとの協働状況】(n=373 ※生成AI利用中の企業)

選択肢 | 割合 |

|---|---|

自社単独で対応する予定 | 42.9% |

わからない | 25.1% |

半年以内に検討予定 | 16.4% |

3ヶ月以内にパートナーを探す | 8.1% |

すでに協働中・選定中 | 7.5% |

分析

- 約32%の企業が半年以内に外部パートナーとの協働を検討・実行予定

- 一方で「自社単独で対応」が42.9%と最多だが、コスト最適化には専門知識が必要

- マルチベンダー対応やカスタムLLM構築の技術難度を考慮すると、今後外部支援へのニーズが高まる可能性

生成AIコストが膨らむ3つの原因

.jpg)

本調査から、企業が直面するコスト課題の主な原因が3つ浮かび上がりました。

【原因1】高額モデルへの一律依存

Claude 、GPT等の高性能モデルは、その精度の高さから多くの業務で採用されています。しかし、すべての業務で高額モデルを使う必要はありません。

具体例

- 簡単な文章要約 → Claude Haikuで十分

- 定型的な分類タスク → Amazon Novaで対応可能

- 画像からのテキスト抽出 → Amazon Textractのほうが安価かつ高精度

【原因2】ワークフローの非効率

多くの企業では、AIワークフローが最適化されておらず、不要なLLM呼び出しが発生しています。

改善ポイント

- 同一質問へのキャッシュ活用

- 簡単な質問は安価モデル、複雑な質問のみ高性能モデルに振り分け

- RAG(検索拡張生成)でコンテキストを最小化

【原因3】費用対効果の可視化不足

「何にいくらかかっているか」が把握できていないため、最適化の優先順位が定まらず、経営層への説明も困難になっています。

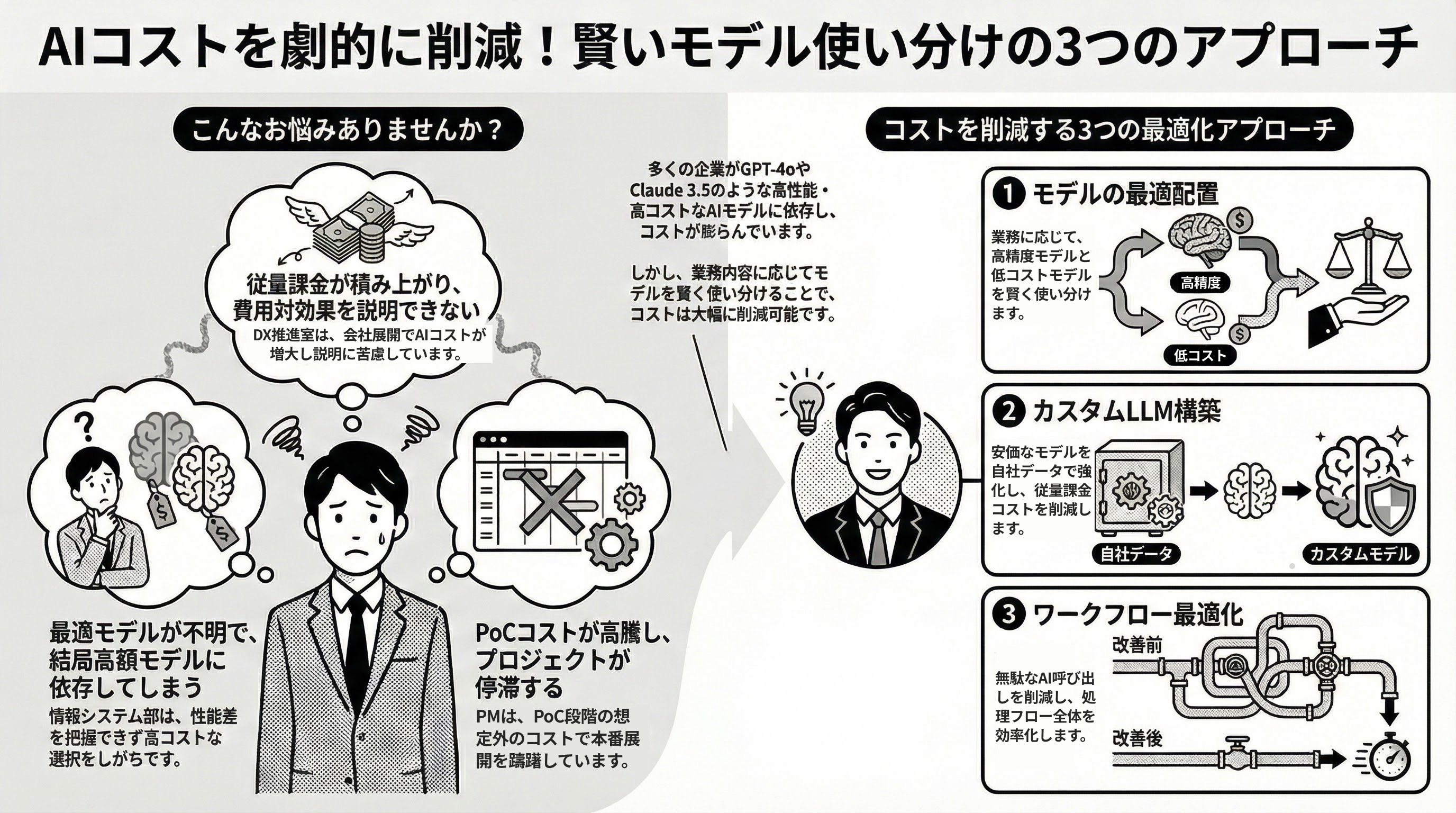

コスト最適化の3つのアプローチ

.jpg)

調査結果を踏まえ、生成AIコストを最適化するための具体的なアプローチを提案します。

【アプローチ1】モデル最適配置設計

業務の難易度・精度要件に応じて、最適なモデルを選定・配置します。

業務タイプ | 推奨モデル | コスト効果 |

|---|---|---|

高精度が必要な分析 | Claude / GPT | 高品質維持 |

一般的な文章生成 | Claude Haiku / GPT mini | 大幅コスト削減 |

大量の定型処理 | Amazon Nova / Titan | 最低コスト |

画像認識 | Amazon Rekognition | LLMの1/10以下 |

【アプローチ2】カスタムLLM構築

自社の業務データでファインチューニングを行い、安価なベースモデルを高精度化します。

メリット

- 従量課金から固定費への移行で予算管理が容易に

- 自社業務に特化した精度向上

- AWS SageMakerでセキュアにホスティング可能

【アプローチ3】AIワークフロー最適化

Dify等のツールを活用し、処理フローを効率化します。

主な施策

- 質問の難易度に応じたモデルルーティング

- キャッシュ戦略によるLLM呼び出し削減

- RAG最適化によるトークン消費削減

- 前処理フィルタリングで不要なAPI呼び出しを防止

まとめ

本調査により、以下の実態が明らかになりました。

- 約4割の企業が「費用対効果の説明・可視化ができていない」

- 約3割の企業が「高額モデルへの依存」をコスト課題として認識

- AIモデルを使い分けている企業はわずか12.8%、最適化の余地が大きい

- 約65%の企業が何らかのコスト削減施策に興味を示している

- 約32%が半年以内に外部パートナーとの協働を検討

生成AIの活用が本格化するにつれ、コスト管理の重要性はますます高まっています。「とりあえず高性能モデル」という運用から脱却し、用途に応じたモデル選定・ワークフロー最適化に取り組むことが、持続可能なAI活用の鍵となります。

LLMコストでお悩みの方へ

「生成AIのコストが膨らんでいるが、どこから手をつければよいかわからない」「高額モデルへの依存から脱却したいが技術的な方法がわからない」という課題をお持ちの企業様は、Ragate株式会社のLLMコスト最適化支援サービスをご検討ください。

Claude・GPT・Gemini等の主要ベンダーのモデル特性を熟知した専門チームが、業務別の最適なモデル選定から、カスタムLLM構築、Difyを活用したAIワークフロー最適化まで、コスト削減を一気通貫で支援いたします。

本調査データの引用・転載について:本記事のデータを引用・転載される場合は、「Ragate株式会社調べ」と出典を明記の上、本記事へのリンクを掲載してください。

.jpg?q=90&fm=webp&w=1200&fit=clip)